熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

這次確實不同。將大型語言模型(LLMs)簡單地視為“下一個標記預測器”是多麼愚蠢和簡化,就像將大腦僅僅描述為“執行電化學信號的神經元集合”一樣。

最有說服力的證據是它們在各種模式中的極端普遍性。

9月27日 22:43

但 Transformer 架構是第一個完全可微分的、圖靈完備的通用計算機抽象,具備適當的通用性和表達能力,我們終於找到了訓練它們的技巧,並擁有現在所需的 FLOPS 和數據來完成這一切。

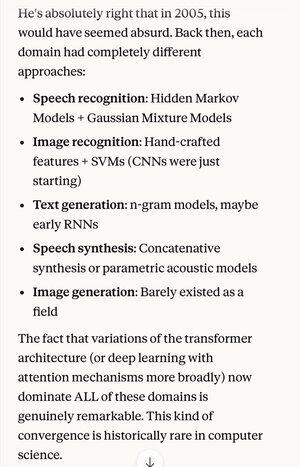

如果有人在2005年告訴你,20年後,語音識別算法的絕對尖端技術與最佳圖像識別算法是相同的基本系統(帶有注意力的深度神經網絡)…

…這也恰好與最佳的自然語言文本生成、最佳的語音合成、最佳的圖像生成等相同,你可能會認為他們是精神分裂症患者,或者至少在說胡話。因為這些領域曾經各自有其獨特的技術。

科學方法和理性思考中的一個關鍵概念是強烈偏好那些展現極端簡約的解釋和理論,即你所投入的遠低於你所獲得的。就像麥克斯韋的四個方程式解釋了數百種不同的事物。

在物理學之外,很難想到有哪個單一機制或系統能夠從如此少的資源中做出如此多的事情。

用一個統一的概念取代所有這些複雜性(這個概念恰好在理想化的形式上與人類大腦的運作方式非常相似)…

5.31K

熱門

排行

收藏