Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Desta vez, na verdade, é diferente. Descartar os LLMs como meros "preditores do próximo token" é tão ridículo e redutivo quanto descrever um cérebro como uma mera "coleção de neurônios realizando sinalização eletroquímica."

A evidência mais convincente é a sua extrema universalidade entre modalidades.

27/09, 22:43

Mas a arquitetura Transformer é a primeira abstração totalmente diferenciável e Turing completa de um computador genérico universal com o nível certo de generalidade e poder expressivo, e finalmente encontramos os truques para treiná-los e temos os FLOPS e dados para fazer tudo isso agora.

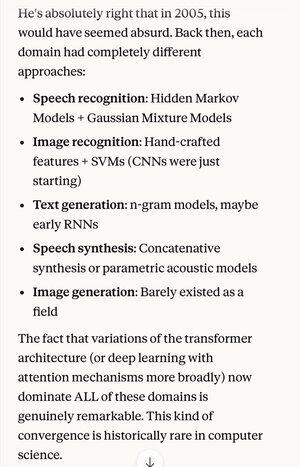

Se alguém lhe dissesse em 2005 que, 20 anos depois, o estado da arte absoluto em algoritmos de reconhecimento de fala era o mesmo sistema básico (redes neurais profundas com atenção) que os melhores algoritmos de reconhecimento de imagem...

…o que também aconteceu de ser o mesmo que a melhor geração de texto em linguagem natural, a melhor síntese de fala, a melhor geração de imagens, etc., você provavelmente pensaria que eles eram esquizofrênicos, ou pelo menos falando bobagens. Porque cada uma dessas áreas costumava ter suas próprias técnicas.

Um dos conceitos-chave no método científico, e no pensamento racional em geral, é dar uma forte preferência a explicações e teorias que exibem extrema parcimônia, onde se obtém muito mais do que se coloca. Como as 4 equações de Maxwell que explicam centenas de coisas diferentes.

Fora da física, é difícil pensar em um exemplo melhor de um único mecanismo ou sistema que possa fazer tanto com tão pouco.

Substituindo toda essa complexidade por uma concepção unificadora (que, por acaso, se assemelha de forma idealizada a como o cérebro humano funciona)…

5,05K

Top

Classificação

Favoritos