Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Denne gangen er faktisk annerledes. Å avvise LLM-er som bare «neste token-prediktorer» er like dumt og reduktivt som å beskrive en hjerne som bare en «samling av nevroner som utfører elektrokjemisk signalering».

Det mest overbevisende beviset er deres ekstreme universalitet på tvers av modaliteter.

27. sep., 22:43

Men Transformer-arkitekturen er den første fullstendig differensierbare, Turing komplette abstraksjonen av en universell generisk datamaskin med riktig nivå av generalitet og uttrykkskraft, og vi fant endelig triksene for å trene dem og ha FLOPS og data til å gjøre alt nå.

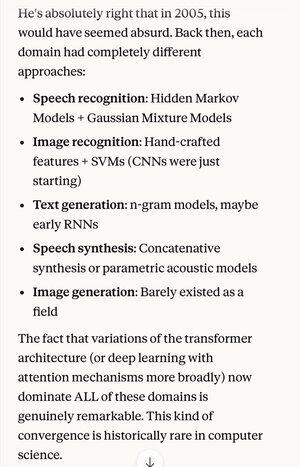

Hvis noen fortalte deg i 2005 at 20 år fra nå var den absolutte toppmoderne innen talegjenkjenningsalgoritmer det samme grunnleggende systemet (dype nevrale nett med oppmerksomhet) som de beste bildegjenkjenningsalgoritmene ...

… som tilfeldigvis også var det samme som den beste tekstgenereringen på naturlig språk, den beste talesyntesen, den beste bildegenereringen osv., du ville sannsynligvis tro at de var schizofrene, eller i det minste snakket tull. Fordi hvert av disse områdene pleide å ha sine egne teknikker.

Et av nøkkelbegrepene i den vitenskapelige metoden, og rasjonell tenkning generelt, er å gi sterk preferanse til forklaringer og teorier som viser ekstrem sparsommelighet, der du får ut langt mer enn du legger inn. Som Maxwells 4 ligninger som forklarer hundrevis av forskjellige ting.

Utenfor fysikk er det vanskelig å tenke seg et bedre eksempel på en enkelt mekanisme eller et system som kan gjøre så mye fra så lite.

Å erstatte all denne kompleksiteten med en samlende oppfatning (som tilfeldigvis ligner i idealisert form på hvordan den menneskelige hjernen fungerer)...

5,31K

Topp

Rangering

Favoritter