Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Den här gången är det faktiskt annorlunda. Att avfärda LLM:er som enbart "nästa tokenprediktorer" är lika dumt och förminskande som att beskriva en hjärna som bara en "samling neuroner som utför elektrokemisk signalering".

Det mest övertygande beviset är deras extrema universalitet över modaliteter.

27 sep. 22:43

Men Transformer-arkitekturen är den första helt differentierbara, Turing-fullständiga abstraktionen av en universell generisk dator med rätt nivå av allmängiltighet och uttryckskraft, och vi hittade äntligen knepen för att träna dem och har FLOPS och data för att göra allt nu.

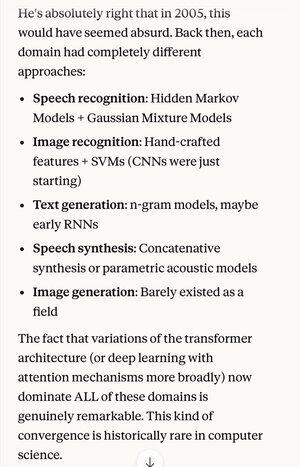

Om någon berättade för dig 2005 att den absoluta toppmoderna tekniken inom taligenkänningsalgoritmer om 20 år var samma grundläggande system (djupa neurala nät med uppmärksamhet) som de bästa bildigenkänningsalgoritmerna ...

… Vilket också råkade vara detsamma som den bästa textgenereringen på naturligt språk, den bästa talsyntesen, den bästa bildgenereringen, etc., du skulle förmodligen tro att de var schizofrena, eller åtminstone pratade nonsens. Eftersom vart och ett av dessa områden brukade ha sina egna tekniker.

Ett av nyckelbegreppen i den vetenskapliga metoden, och rationellt tänkande i allmänhet, är att ge stark preferens åt förklaringar och teorier som uppvisar extrem sparsamhet, där man får ut mycket mer än man lägger in. Som Maxwells 4 ekvationer som förklarar hundratals olika saker.

Utanför fysiken är det svårt att tänka sig ett bättre exempel på en enskild mekanism eller ett system som kan göra så mycket från så lite.

Att ersätta all denna komplexitet med en förenande föreställning (som bara råkar likna i idealiserad form hur den mänskliga hjärnan fungerar)...

5,31K

Topp

Rankning

Favoriter