Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tämä kerta on itse asiassa erilainen. LLM:ien hylkääminen pelkkinä "seuraavien merkkien ennustajina" on yhtä typerää ja pelkistävää kuin aivojen kuvaaminen pelkäksi "sähkökemiallista signalointia suorittavien hermosolujen kokoelmaksi".

Vakuuttavin todiste on niiden äärimmäinen universaalisuus eri modaliteeteissa.

27.9. klo 22.43

Mutta Transformer-arkkitehtuuri on ensimmäinen täysin differentioituva, Turingin täydellinen abstraktio universaalista geneerisestä tietokoneesta, jolla on oikea yleisyys ja ilmaisuvoima, ja löysimme vihdoin temput niiden kouluttamiseen ja meillä on FLOPS ja data sen kaiken tekemiseen nyt.

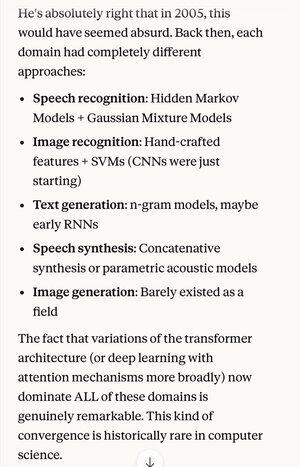

Jos joku kertoisi sinulle vuonna 2005, että 20 vuoden kuluttua puheentunnistusalgoritmien absoluuttinen uusin tekniikka on sama perusjärjestelmä (syvät hermoverkot, joissa on huomiota) kuin parhaat kuvantunnistusalgoritmit...

… joka sattui myös olemaan sama kuin paras luonnollisen kielen tekstinluonti, paras puhesynteesi, paras kuvien luominen jne., luultavasti luulisi, että ne ovat skitsofreenisia tai ainakin puhuvat hölynpölyä. Koska jokaisella näistä alueista oli ennen omat tekniikkansa.

Yksi tieteellisen menetelmän ja rationaalisen ajattelun avainkäsitteistä on suosia selityksiä ja teorioita, jotka osoittavat äärimmäistä niukkuutta, jolloin saat paljon enemmän ulos kuin panostat. Kuten Maxwellin 4 yhtälöä, jotka selittävät satoja eri asioita.

Fysiikan ulkopuolella on vaikea kuvitella parempaa esimerkkiä yhdestä mekanismista tai järjestelmästä, joka voi tehdä niin paljon niin vähällä.

Kaiken tämän monimutkaisuuden korvaaminen yhdellä yhdistävällä käsityksellä (joka sattuu muistuttamaan läheisesti idealisoidussa muodossa sitä, miten ihmisaivot toimivat)...

5,05K

Johtavat

Rankkaus

Suosikit