热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

这次确实不同。将大型语言模型(LLMs)视为仅仅是“下一个标记预测器”是多么愚蠢和简化,就像将大脑描述为仅仅是“执行电化学信号传递的神经元集合”一样。

最有说服力的证据是它们在各种模式下的极端普遍性。

9月27日 22:43

但是,Transformer架构是第一个完全可微分的、图灵完备的通用计算机抽象,具有适当的通用性和表达能力,我们终于找到了训练它们的技巧,并且现在拥有足够的FLOPS和数据来完成这一切。

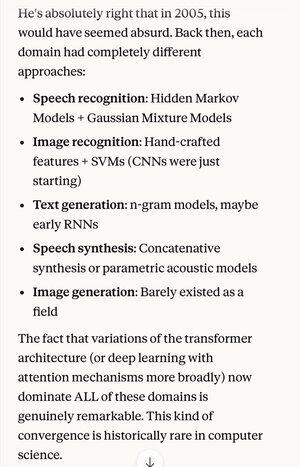

如果有人在2005年告诉你,20年后,语音识别算法的绝对最先进技术与最佳图像识别算法是相同的基本系统(带有注意力的深度神经网络)……

……这也恰好与最佳的自然语言文本生成、最佳的语音合成、最佳的图像生成等相同,你可能会认为他们是精神分裂症患者,或者至少是在说胡话。因为这些领域曾经各自有其独特的技术。

科学方法和理性思维中的一个关键概念是优先考虑那些表现出极端简约的解释和理论,即你所投入的远远少于你所获得的。就像麦克斯韦的四个方程解释了数百种不同的事物。

在物理学之外,很难想到还有什么更好的例子,能够用如此少的东西实现如此多的功能。

用一个统一的概念替代所有这些复杂性(恰好在理想化的形式上与人类大脑的工作方式非常相似)…

5.32K

热门

排行

收藏