Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Esta vez es, de hecho, diferente. Desestimar a los LLM como meros "predictores del siguiente token" es tan tonto y reductivo como describir un cerebro como una mera "colección de neuronas realizando señales electroquímicas."

La evidencia más convincente es su extrema universalidad a través de modalidades.

27 sept, 22:43

Pero la arquitectura Transformer es la primera abstracción completamente diferenciable y Turing completa de una computadora genérica universal con el nivel adecuado de generalidad y poder expresivo, y finalmente encontramos los trucos para entrenarlas y tenemos los FLOPS y los datos para hacerlo todo ahora.

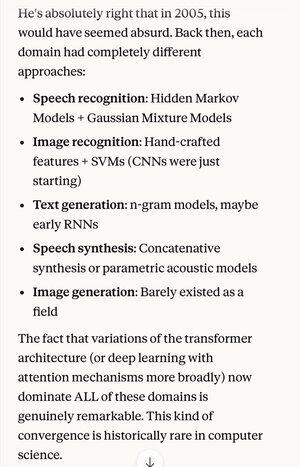

Si alguien te hubiera dicho en 2005 que, 20 años después, el estado absoluto del arte en algoritmos de reconocimiento de voz era el mismo sistema básico (redes neuronales profundas con atención) que los mejores algoritmos de reconocimiento de imágenes...

…lo que también resultó ser lo mismo que la mejor generación de texto en lenguaje natural, la mejor síntesis de voz, la mejor generación de imágenes, etc., probablemente pensarías que estaban esquizofrénicos, o al menos hablando tonterías. Porque cada una de esas áreas solía tener sus propias técnicas.

Uno de los conceptos clave en el método científico, y en el pensamiento racional en general, es dar una fuerte preferencia a explicaciones y teorías que exhiben una extrema parsimonia, donde obtienes mucho más de lo que inviertes. Como las 4 ecuaciones de Maxwell que explican cientos de cosas diferentes.

Fuera de la física, es difícil pensar en un mejor ejemplo de un solo mecanismo o sistema que pueda hacer tanto con tan poco.

Reemplazando toda esta complejidad con una concepción unificadora (que resulta ser muy parecida en forma idealizada a cómo funciona el cerebro humano)…

5,05K

Parte superior

Clasificación

Favoritos