Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

De data aceasta este, de fapt, diferit. Respingerea LLM-urilor ca simpli "următori predictori de simboluri" este la fel de prostească și reductivă ca și descrierea unui creier ca o simplă "colecție de neuroni care efectuează semnalizare electrochimică".

Cea mai convingătoare dovadă este universalitatea lor extremă între modalități.

27 sept., 22:43

Dar arhitectura Transformer este prima abstracție completă Turing complet diferențiabilă a unui computer generic universal cu nivelul potrivit de generalitate și putere expresivă, și am găsit în sfârșit trucurile pentru a-i antrena și a avea FLOPS și date pentru a face totul acum.

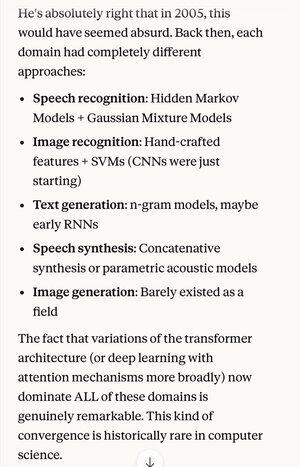

Dacă cineva ți-ar fi spus în 2005 că, peste 20 de ani, stadiul absolut al tehnologiei în algoritmii de recunoaștere a vorbirii este același sistem de bază (rețele neuronale profunde cu atenție) ca și cei mai buni algoritmi de recunoaștere a imaginilor...

… care s-a întâmplat să fie același lucru cu cea mai bună generație de text în limbaj natural, cea mai bună sinteză vocală, cea mai bună generare de imagini etc., probabil ai crede că sunt schizofrenice, sau cel puțin spun prostii. Pentru că fiecare dintre aceste zone avea propriile tehnici.

Unul dintre conceptele cheie ale metodei științifice, și ale gândirii raționale în general, este să dai o preferință puternică explicațiilor și teoriilor care prezintă o parcimonie extremă, în care scoți mult mai mult decât pui. Cum ar fi cele 4 ecuații ale lui Maxwell care explică sute de lucruri diferite.

În afara fizicii, este greu să ne gândim la un exemplu mai bun de mecanism sau sistem care poate face atât de mult din atât de puțin.

Înlocuirea acestei complexități cu o singură concepție unificatoare (care se întâmplă să semene foarte mult în formă idealizată cu modul în care funcționează creierul uman)...

5,05K

Limită superioară

Clasament

Favorite