Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

На этот раз все действительно иначе. Считать LLM всего лишь «предсказателями следующего токена» так же глупо и упрощенно, как описывать мозг как простую «коллекцию нейронов, выполняющих электрохимическую сигнализацию».

Самое убедительное доказательство — это их крайняя универсальность в различных модальностях.

27 сент., 22:43

Но архитектура Transformer — это первая полностью дифференцируемая, тьюринговская абстракция универсального общего компьютера с правильным уровнем общности и выразительной мощи, и мы наконец нашли приемы для их обучения и имеем FLOPS и данные, чтобы сделать это все сейчас.

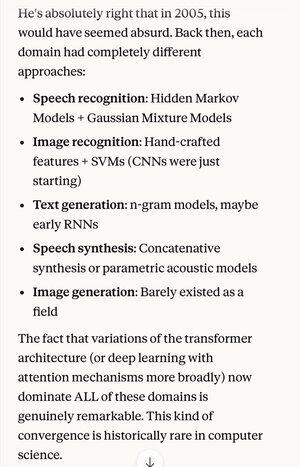

Если бы кто-то сказал вам в 2005 году, что через 20 лет абсолютное состояние искусства в алгоритмах распознавания речи будет тем же самым базовым системой (глубокие нейронные сети с вниманием), что и лучшие алгоритмы распознавания изображений…

…что также совпадало с лучшей генерацией текстов на естественном языке, лучшим синтезом речи, лучшей генерацией изображений и т. д., вы, вероятно, подумали бы, что они шизофреничны или, по крайней мере, говорят чепуху. Потому что каждая из этих областей раньше имела свои собственные техники.

Одним из ключевых понятий в научном методе и рациональном мышлении в целом является сильное предпочтение объяснениям и теориям, которые демонстрируют крайнюю экономию, когда вы получаете гораздо больше, чем вкладываете. Как уравнения Максвелла, объясняющие сотни различных вещей.

Вне физики трудно представить себе лучший пример единого механизма или системы, которые могут делать так много из столь малого.

Замена всей этой сложности одной объединяющей концепцией (которая, как ни странно, в идеализированной форме очень похожа на то, как работает человеческий мозг)…

5,05K

Топ

Рейтинг

Избранное