Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Questa volta è, in effetti, diversa. Sminuire i LLM come semplici "predittori del prossimo token" è tanto sciocco e riduttivo quanto descrivere un cervello come una mera "collezione di neuroni che eseguono segnali elettrochimici."

La prova più convincente è la loro estrema universalità attraverso le modalità.

27 set, 22:43

Ma l'architettura Transformer è la prima astrazione completamente differenziabile e Turing completa di un computer generico universale con il giusto livello di generalità e potere espressivo, e finalmente abbiamo trovato i trucchi per addestrarli e abbiamo i FLOPS e i dati per farlo tutto ora.

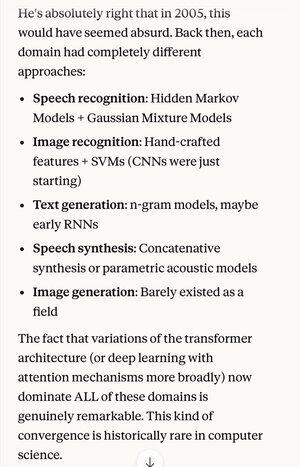

Se qualcuno ti avesse detto nel 2005 che, 20 anni dopo, lo stato dell'arte assoluto negli algoritmi di riconoscimento vocale sarebbe stato lo stesso sistema di base (reti neurali profonde con attenzione) degli migliori algoritmi di riconoscimento delle immagini...

…che si rivelava anche essere la stessa della migliore generazione di testo in linguaggio naturale, la migliore sintesi vocale, la migliore generazione di immagini, ecc., probabilmente penseresti che fossero schizofrenici, o almeno che stessero dicendo sciocchezze. Perché ognuna di quelle aree aveva le proprie tecniche.

Uno dei concetti chiave nel metodo scientifico e nel pensiero razionale in generale è dare una forte preferenza a spiegazioni e teorie che mostrano un'estrema parsimonia, dove si ottiene molto di più di quanto si mette. Come le 4 equazioni di Maxwell che spiegano centinaia di cose diverse.

Al di fuori della fisica, è difficile pensare a un esempio migliore di un singolo meccanismo o sistema che possa fare così tanto con così poco.

Sostituendo tutta questa complessità con un'unica concezione unificante (che per caso assomiglia in forma idealizzata a come funziona il cervello umano)…

5,31K

Principali

Ranking

Preferiti