Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tentokrát je to ve skutečnosti jiné. Zavrhovat LLM jako pouhé "prediktory příštího tokenu" je stejně hloupé a zjednodušující jako popisovat mozek jako pouhou "sbírku neuronů provádějících elektrochemickou signalizaci".

Nejpřesvědčivějším důkazem je jejich extrémní univerzálnost napříč modalitami.

27. 9. 22:43

Ale architektura Transformeru je první plně diferencovatelná, Turingova kompletní abstrakce univerzálního generického počítače se správnou úrovní obecnosti a expresivní síly, a my jsme konečně našli triky, jak je trénovat a mít FLOPS a data, jak to všechno dělat už teď.

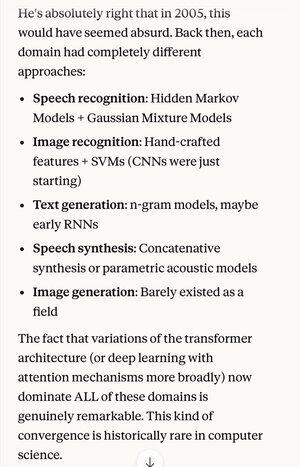

Pokud by vám někdo v roce 2005 řekl, že za 20 let bude absolutním stavem v algoritmech rozpoznávání řeči stejný základní systém (hluboké neuronové sítě s pozorností) jako nejlepší algoritmy pro rozpoznávání obrazu...

… což je shodou okolností také totéž jako nejlepší generování textu v přirozeném jazyce, nejlepší syntéza řeči, nejlepší generování obrázků atd., pravděpodobně byste si mysleli, že jsou schizofrenní, nebo alespoň mluví nesmysly. Protože každá z těchto oblastí měla své vlastní techniky.

Jedním z klíčových konceptů vědecké metody a racionálního myšlení obecně je upřednostňování vysvětlení a teorií, které vykazují extrémní šetrnost, kdy se z toho dostanete mnohem více, než jste vložili. Jako Maxwellovy 4 rovnice vysvětlující stovky různých věcí.

Mimo fyziku je těžké vymyslet lepší příklad jediného mechanismu nebo systému, který dokáže tolik z tak mála.

Nahrazení celé této složitosti jednou sjednocující koncepcí (která se shodou okolností velmi podobá v idealizované formě tomu, jak funguje lidský mozek)...

5,3K

Top

Hodnocení

Oblíbené