Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Cette fois, c'est en fait différent. Écarter les LLM comme de simples "prédicteurs de jetons suivants" est aussi absurde et réducteur que de décrire un cerveau comme une simple "collection de neurones effectuant des signaux électrochimiques."

La preuve la plus convaincante est leur extrême universalité à travers les modalités.

27 sept., 22:43

Mais l'architecture Transformer est la première abstraction entièrement différentiable et Turing complète d'un ordinateur générique universel avec le bon niveau de généralité et de puissance expressive, et nous avons enfin trouvé les astuces pour les entraîner et avons les FLOPS et les données nécessaires pour tout faire maintenant.

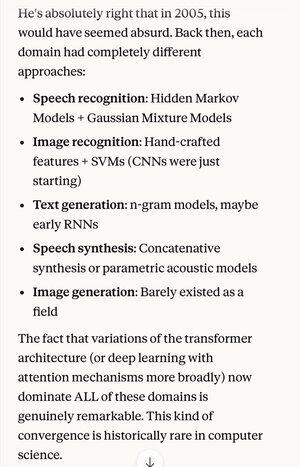

Si quelqu'un vous avait dit en 2005 que, 20 ans plus tard, l'état de l'art en matière d'algorithmes de reconnaissance vocale était le même système de base (réseaux neuronaux profonds avec attention) que les meilleurs algorithmes de reconnaissance d'images...

…ce qui s'est également avéré être le meilleur en génération de texte en langage naturel, la meilleure synthèse vocale, la meilleure génération d'images, etc., vous penseriez probablement qu'ils étaient schizophrènes, ou du moins qu'ils disaient des absurdités. Parce que chacun de ces domaines avait autrefois ses propres techniques.

L'un des concepts clés de la méthode scientifique, et de la pensée rationnelle en général, est de donner une forte préférence aux explications et aux théories qui présentent une extrême parcimonie, où l'on obtient beaucoup plus que ce que l'on investit. Comme les 4 équations de Maxwell qui expliquent des centaines de choses différentes.

En dehors de la physique, il est difficile de penser à un meilleur exemple d'un seul mécanisme ou système capable de faire tant avec si peu.

Remplacer toute cette complexité par une seule conception unificatrice (qui ressemble d'ailleurs de manière idéalisée à la façon dont fonctionne le cerveau humain)…

5,05K

Meilleurs

Classement

Favoris