Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

CodecFlow

Camada de execução para Operadores de IA e Robótica em @Solana

CA:69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

Os VLAs ainda são muito novos e muitas pessoas acham difícil entender a diferença entre VLAs e LLMs.

Aqui está uma análise aprofundada de como esses sistemas de IA diferem em raciocínio, percepção e ação. Parte 1.

Vamos detalhar as principais distinções e como os agentes de IA envolvidos em um LLM diferem dos agentes operacionais que usam modelos VLA:

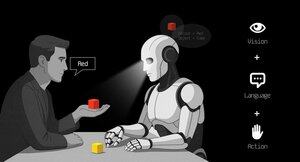

1. Perceber: Como eles percebem o mundo

Agente (LLM): Processa texto ou dados estruturados, como JSON, APIs e, às vezes, imagens. É como um cérebro trabalhando com entradas limpas e abstraídas. Pense em ler um manual ou analisar uma planilha. Ótimo para ambientes estruturados, mas limitado pelo que é alimentado.

Operador (VLA): Vê pixels brutos e em tempo real de câmeras, além de dados de sensores (por exemplo, toque, posição) e propriocepção (consciência de si mesmo em movimento). É como navegar pelo mundo com olhos e sentidos, prosperando em ambientes dinâmicos e desordenados, como interfaces de usuário ou espaços físicos.

2. Agir: Como eles interagem

Agente: Age chamando funções, ferramentas ou APIs. Imagine-o como um gerente enviando instruções precisas, como "reserve um voo via Expedia API." É deliberado, mas depende de ferramentas pré-construídas e interfaces claras.

Operador: Executa ações contínuas e de baixo nível, como mover um cursor de mouse, digitar ou controlar articulações de robôs. É como um trabalhador habilidoso manipulando diretamente o ambiente, ideal para tarefas que exigem precisão em tempo real.

3. Controle: Como eles tomam decisões

Agente: Segue um ciclo lento e reflexivo: planejar, chamar uma ferramenta, avaliar o resultado, repetir. É limitado por tokens (restrito ao processamento de texto) e por rede (aguardando respostas de API). Isso o torna metódico, mas lento para tarefas em tempo real.

Operador: Opera, tomando decisões passo a passo em um ciclo de feedback apertado. Pense nisso como um jogador reagindo instantaneamente ao que está na tela. Essa velocidade permite uma interação fluida, mas exige um processamento robusto em tempo real.

4. Dados para Aprender: O que alimenta seu treinamento

Agente: Treinado em vastos corpora de texto, instruções, documentação ou conjuntos de dados RAG (Geração Aumentada por Recuperação). Aprende com livros, códigos ou FAQs, destacando-se no raciocínio sobre conhecimento estruturado.

Operador: Aprende com demonstrações (por exemplo, vídeos de humanos realizando tarefas), registros de teleoperação ou sinais de recompensa. É como aprender assistindo e praticando, perfeito para tarefas onde instruções explícitas são escassas.

5. Modos de Falha: Onde eles quebram

Agente: Propenso a alucinações (inventando respostas) ou planos de longo prazo frágeis que desmoronam se um passo falhar. É como um estrategista que pensa demais ou interpreta mal a situação.

Operador: Enfrenta mudança de covariáveis (quando os dados de treinamento não correspondem às condições do mundo real) ou erros acumulativos no controle (pequenos erros se acumulam). É como um motorista perdendo o controle em uma estrada desconhecida.

6. Infraestrutura: A tecnologia por trás deles

Agente: Depende de um prompt/router para decidir quais ferramentas chamar, um registro de ferramentas para funções disponíveis e memória/RAG para contexto. É uma configuração modular, como um centro de comando orquestrando tarefas.

Operador: Necessita de pipelines de ingestão de vídeo, um servidor de ações para controle em tempo real, um escudo de segurança para prevenir ações prejudiciais e um buffer de replay para armazenar experiências. É um sistema de alto desempenho construído para ambientes dinâmicos.

7. Onde Cada Um Brilha: Seus pontos fortes

Agente: Domina em fluxos de trabalho com APIs limpas (por exemplo, automatizando processos de negócios), raciocínio sobre documentos (por exemplo, resumindo relatórios) ou geração de código. É sua escolha para tarefas estruturadas e de alto nível.

Operador: Destaca-se em ambientes desordenados, sem APIs, como navegar em interfaces de usuário complicadas, controlar robôs ou enfrentar tarefas semelhantes a jogos. Se envolve interação em tempo real com sistemas imprevisíveis, o VLA é o rei.

8. Modelo Mental: Planejador + Executor

Pense no Agente LLM como o planejador: ele divide tarefas complexas em metas claras e lógicas.

O Operador VLA é o executor, realizando essas metas interagindo diretamente com pixels ou sistemas físicos. Um verificador (outro sistema ou agente) monitora os resultados para garantir o sucesso.

$CODEC

1,2K

O Codecflow Optr oferece uma abordagem unificada para construir agentes que veem, raciocinam e agem em ambientes digitais e físicos. Seja automatizando fluxos de trabalho de desktop, controlando braços robóticos ou testando em simulação, utiliza o mesmo modelo mental e primitivos.

Louround 🥂21/08/2025

Dips in a bull market are meant to be bought, especially on projects with big catalysts

We all know that AI is the narrative of this cycle, started by ai16z and Virtuals last year.

My bet is that the market will focus on more complex and sophisticated technologies such as VLAs, and let me tell you why.

LLMs (Large Language Models) mainly read and write text: they’re great at explaining, planning, and generating instructions, but they don’t by themselves control motors or interact with the physical world (as you may have experienced with chatgpt).

VLAs (Vision Language Action models) differ from LLMs as they are multimodal systems that look at things (vision), understand instructions (language), and directly produce actions. It's like telling a robot to pick up a red cup and then moving its arm to do it.

VLAs are trained on examples that pair images/video + instructions + real action traces (how a robot actually moved), and they must run fast and safely in real time. LLMs on their side are trained on huge text collections and focus on reasoning and language tasks.

TL;DR LLMs think and speak whil VLAs see, reason, and act.

As you can see, VLAs are a major addition to LLMs and will notably enable the next 0 to 1 innovation in the overall economy that will be robotics. A majority of investment funds are allocating a large part of their investments into this sector, seen as the next logical evolution in the AI industry.

I already made a post a while ago on the current leader in the crypto market, @codecopenflow, which did not raise capital (fair launch) yet is shipping cutting-edge products and currently sitting at $23M FDV.

For information, other crypto competitors raised $20m ( @openmind_agi) at what is probably a $200M to $300M ++ FDV while no product or community has been built and shipped yet.

What makes Codec a leading project in the sector is that they tackle a crucial bottleneck in robotics and AI, which is the difficulty to have all the AI tools interact together. Let me explain.

Their latest release, OPTR (operator), is a toolkit that helps build operators capable of interacting on multiple platforms such as robots, desktops, browsers, or simulations. The objective of an operator is to see, reason, and act (VLA) in both digital (computers) and physical (robots) worlds.

This toolkit serves as core infrastructure for robotic teams aiming to test their product and enhance the overall process by providing a unified experience instead of separate ones for web browsers, simulations, or robots. This essentially makes the operator adaptive and autonomous regardless of its environment.

So you get it, it will save big time for companies and developers who previously had to go through each step manually and where you can save time you can save money.

It will also enable Codec to build their own operator projects and launch new capacities relatively fast onto the market, notably through their marketplace.

TL;DR: You probably have seen videos of robots folding tissues, sorting boxes, or jumping on various elements. They have all been trained for this very specific use case, and unfortunately, one skill cannot be re-used in another environment like a human could do. OPTR from Codec solves this by making skills transferrable among environments and situations, making training and development a lot faster and cheaper for enterprises.

This is why Codec is so interesting in unifying the digital world with the physical world.

$CODEC, Coded.

1,18K

A empresa de pesquisa @epochbiz (por @ZoomerOracle) publicou um artigo de pesquisa detalhado sobre o CodecFlow.

Não perca.

$CODEC

epoch_19/08/2025

$CODEC está a preparar-se para ser a melhor opção como jogo onchain para Robótica

O artigo de pesquisa sobre @codecopenflow já está disponível 🤖

1,22K

Top

Classificação

Favoritos