Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

CodecFlow

Livello di esecuzione per operatori di intelligenza artificiale e robotica su @Solana

CA:69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

I VLA sono ancora molto nuovi e molte persone trovano difficile comprendere la differenza tra VLA e LLM.

Ecco un'analisi approfondita su come questi sistemi AI differiscono in ragionamento, percezione e azione. Parte 1.

Analizziamo le principali distinzioni e come gli agenti AI avvolti attorno a un LLM differiscano dagli agenti operativi che utilizzano modelli VLA:

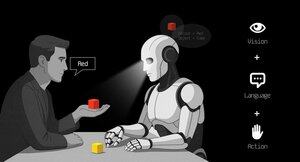

1. Percezione: Come percepiscono il mondo

Agente (LLM): Elabora testo o dati strutturati, ad esempio JSON, API e a volte immagini. È come un cervello che lavora con input puliti e astratti. Pensa a leggere un manuale o analizzare un foglio di calcolo. Ottimo per ambienti strutturati ma limitato da ciò che gli viene fornito.

Operatore (VLA): Vede pixel grezzi e in tempo reale dalle telecamere, oltre ai dati dei sensori (ad es., tatto, posizione) e alla propriocezione (consapevolezza del movimento). È come navigare nel mondo con occhi e sensi, prosperando in ambienti dinamici e disordinati come interfacce utente o spazi fisici.

2. Azione: Come interagiscono

Agente: Agisce chiamando funzioni, strumenti o API. Immaginalo come un manager che invia istruzioni precise come "prenota un volo tramite l'API di Expedia." È deliberato ma si basa su strumenti predefiniti e interfacce chiare.

Operatore: Esegue azioni continue e a basso livello, come muovere un cursore del mouse, digitare o controllare le articolazioni di un robot. È come un lavoratore esperto che manipola direttamente l'ambiente, ideale per compiti che richiedono precisione in tempo reale.

3. Controllo: Come prendono decisioni

Agente: Segue un ciclo lento e riflessivo: pianifica, chiama uno strumento, valuta il risultato, ripete. È vincolato ai token (limitato dall'elaborazione del testo) e vincolato alla rete (in attesa delle risposte API). Questo lo rende metodico ma lento per compiti in tempo reale.

Operatore: Opera, prendendo decisioni passo dopo passo in un ciclo di feedback stretto. Pensa a un videogiocatore che reagisce istantaneamente a ciò che appare sullo schermo. Questa velocità consente un'interazione fluida ma richiede un'elaborazione robusta in tempo reale.

4. Dati per apprendere: Cosa alimenta il loro addestramento

Agente: Addestrato su vasti corpora di testo, istruzioni, documentazione o set di dati RAG (Generazione Aumentata da Recupero). Impara da libri, codice o FAQ, eccellendo nel ragionamento su conoscenze strutturate.

Operatore: Impara da dimostrazioni (ad es., video di umani che eseguono compiti), registri di teleoperazione o segnali di ricompensa. È come imparare guardando e praticando, perfetto per compiti in cui le istruzioni esplicite sono scarse.

5. Modi di fallimento: Dove si rompono

Agente: Incline all'allucinazione (inventare risposte) o a piani a lungo termine fragili che si rompono se un passo fallisce. È come un stratega che riflette troppo o interpreta male la situazione.

Operatore: Affronta il cambiamento di covariate (quando i dati di addestramento non corrispondono alle condizioni del mondo reale) o errori composti nel controllo (piccoli errori che si accumulano). È come un guidatore che perde il controllo su una strada sconosciuta.

6. Infrastruttura: La tecnologia dietro di loro

Agente: Si basa su un prompt/router per decidere quali strumenti chiamare, un registro degli strumenti per le funzioni disponibili e memoria/RAG per il contesto. È un setup modulare, come un centro di comando che orchestra i compiti.

Operatore: Ha bisogno di pipeline di ingestione video, un server di azione per il controllo in tempo reale, uno scudo di sicurezza per prevenire azioni dannose e un buffer di riproduzione per memorizzare le esperienze. È un sistema ad alte prestazioni costruito per ambienti dinamici.

7. Dove brillano: I loro punti di forza

Agente: Domina nei flussi di lavoro con API pulite (ad es., automazione dei processi aziendali), ragionamento su documenti (ad es., riassumere rapporti) o generazione di codice. È il tuo punto di riferimento per compiti strutturati e di alto livello.

Operatore: Eccelle in ambienti disordinati, privi di API, come navigare in interfacce utente ingombranti, controllare robot o affrontare compiti simili a giochi. Se comporta interazione in tempo reale con sistemi imprevedibili, il VLA è il re.

8. Modello mentale: Pianificatore + Esecutore

Pensa all'Agente LLM come al pianificatore: scompone compiti complessi in obiettivi chiari e logici.

L'Operatore VLA è l'esecutore, che realizza quegli obiettivi interagendo direttamente con pixel o sistemi fisici. Un controllore (un altro sistema o agente) monitora i risultati per garantire il successo.

$CODEC

1,19K

Codecflow Optr offre un approccio unificato per costruire agenti che vedono, ragionano e agiscono in ambienti digitali e fisici. Che si tratti di automatizzare flussi di lavoro su desktop, controllare bracci robotici o testare in simulazione, utilizza lo stesso modello mentale e le stesse primitive.

Louround 🥂21 ago 2025

Dips in a bull market are meant to be bought, especially on projects with big catalysts

We all know that AI is the narrative of this cycle, started by ai16z and Virtuals last year.

My bet is that the market will focus on more complex and sophisticated technologies such as VLAs, and let me tell you why.

LLMs (Large Language Models) mainly read and write text: they’re great at explaining, planning, and generating instructions, but they don’t by themselves control motors or interact with the physical world (as you may have experienced with chatgpt).

VLAs (Vision Language Action models) differ from LLMs as they are multimodal systems that look at things (vision), understand instructions (language), and directly produce actions. It's like telling a robot to pick up a red cup and then moving its arm to do it.

VLAs are trained on examples that pair images/video + instructions + real action traces (how a robot actually moved), and they must run fast and safely in real time. LLMs on their side are trained on huge text collections and focus on reasoning and language tasks.

TL;DR LLMs think and speak whil VLAs see, reason, and act.

As you can see, VLAs are a major addition to LLMs and will notably enable the next 0 to 1 innovation in the overall economy that will be robotics. A majority of investment funds are allocating a large part of their investments into this sector, seen as the next logical evolution in the AI industry.

I already made a post a while ago on the current leader in the crypto market, @codecopenflow, which did not raise capital (fair launch) yet is shipping cutting-edge products and currently sitting at $23M FDV.

For information, other crypto competitors raised $20m ( @openmind_agi) at what is probably a $200M to $300M ++ FDV while no product or community has been built and shipped yet.

What makes Codec a leading project in the sector is that they tackle a crucial bottleneck in robotics and AI, which is the difficulty to have all the AI tools interact together. Let me explain.

Their latest release, OPTR (operator), is a toolkit that helps build operators capable of interacting on multiple platforms such as robots, desktops, browsers, or simulations. The objective of an operator is to see, reason, and act (VLA) in both digital (computers) and physical (robots) worlds.

This toolkit serves as core infrastructure for robotic teams aiming to test their product and enhance the overall process by providing a unified experience instead of separate ones for web browsers, simulations, or robots. This essentially makes the operator adaptive and autonomous regardless of its environment.

So you get it, it will save big time for companies and developers who previously had to go through each step manually and where you can save time you can save money.

It will also enable Codec to build their own operator projects and launch new capacities relatively fast onto the market, notably through their marketplace.

TL;DR: You probably have seen videos of robots folding tissues, sorting boxes, or jumping on various elements. They have all been trained for this very specific use case, and unfortunately, one skill cannot be re-used in another environment like a human could do. OPTR from Codec solves this by making skills transferrable among environments and situations, making training and development a lot faster and cheaper for enterprises.

This is why Codec is so interesting in unifying the digital world with the physical world.

$CODEC, Coded.

1,18K

La società di ricerca @epochbiz (di @ZoomerOracle) ha pubblicato un dettagliato studio su CodecFlow.

Non perdertelo.

$CODEC

epoch_19 ago 2025

$CODEC si sta preparando per essere la migliore opzione come gioco onchain per la Robotica

L'articolo di ricerca su @codecopenflow è ora disponibile su 🤖

1,22K

Principali

Ranking

Preferiti