Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

CodecFlow

Körningslager för AI-operatörer och robotik på @Solana

CA:69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

VLA:er är fortfarande väldigt nya och många människor har svårt att förstå skillnaden mellan VLA:er och LLM:er.

Här är en djupdykning i hur dessa AI-system skiljer sig åt när det gäller resonemang, avkänning och handling. Del 1.

Låt oss dela upp de viktigaste skillnaderna och hur AI-agenter lindade runt en LLM skiljer sig från operatörsagenter som använder VLA-modeller:

1. Känsla: Hur de uppfattar världen

Agent (LLM): Bearbetar text eller strukturerade data, t.ex. JSON, API:er och ibland bilder. Det är som en hjärna som arbetar med rena, abstraherade indata. Tänk dig att läsa en manual eller analysera ett kalkylblad. Perfekt för strukturerade miljöer men begränsad av vad som matas till den.

Operatör (VLA): Ser råa pixlar i realtid från kameror, plus sensordata (t.ex. beröring, position) och proprioception (självmedvetenhet om rörelse). Det är som att navigera i världen med ögon och sinnen och trivas i dynamiska, röriga miljöer som användargränssnitt eller fysiska utrymmen.

2. Agera: Hur de interagerar

Agent: Fungerar genom att anropa funktioner, verktyg eller API:er. Föreställ dig att en chef skickar exakta instruktioner som "boka ett flyg via Expedia API". Det är medvetet men förlitar sig på förbyggda verktyg och tydliga gränssnitt.

Operator: Utför kontinuerliga åtgärder på låg nivå, som att flytta en muspekare, skriva eller styra robotleder. Det är som en skicklig arbetare som direkt manipulerar miljön, perfekt för uppgifter som kräver precision i realtid.

3. Kontroll: Hur de fattar beslut

Agent: Följer en långsam, reflekterande loop: planera, anropa ett verktyg, utvärdera resultatet, upprepa. Den är tokenbunden (begränsas av textbearbetning) och nätverksbunden (väntar på API-svar). Detta gör det metodiskt men trögt för uppgifter i realtid.

Operatör: Arbetar och fattar stegvisa beslut i en tät återkopplingsslinga. Tänk på det som en spelare som reagerar direkt på det som visas på skärmen. Denna hastighet möjliggör smidig interaktion men kräver robust bearbetning i realtid.

4. Data att lära sig: Vad som driver deras utbildning

Agent: Utbildad på omfattande textkorpusar, instruktioner, dokumentation eller RAG-datauppsättningar (Retrieval-Augmented Generation). Den lär sig från böcker, kod eller vanliga frågor och svar och utmärker sig på att resonera framför strukturerad kunskap.

Operatör: Lär sig från demonstrationer (t.ex. videor av människor som utför uppgifter), fjärrstyrningsloggar eller belöningssignaler. Det är som att lära sig genom att titta och öva, perfekt för uppgifter där explicita instruktioner är knapphändiga.

5. Fellägen: Var de går sönder

Agent: Benägen att hallucinera (hitta på svar) eller bräckliga planer med lång horisont som går i stöpet om ett steg misslyckas. Det är som en strateg som övertänker eller misstolkar situationen.

Operatör: Står inför kovariatförskjutning (när träningsdata inte matchar verkliga förhållanden) eller sammansatta fel i kontrollen (små misstag snöbollseffekt). Det är som en förare som tappar kontrollen på en okänd väg.

6. Infra: Tekniken bakom dem

Agent: Förlitar sig på en prompt/router för att bestämma vilka verktyg som ska anropas, ett verktygsregister för tillgängliga funktioner och minne/RAG för kontext. Det är en modulär installation, som en kommandocentral som orkestrerar uppgifter.

Operatör: Behöver pipelines för videoinmatning, en åtgärdsserver för realtidskontroll, en säkerhetssköld för att förhindra skadliga åtgärder och en uppspelningsbuffert för att lagra upplevelser. Det är ett högpresterande system byggt för dynamiska miljöer.

7. Var var och en lyser: Deras söta fläckar

Agent: Dominerar i arbetsflöden med rena API:er (t.ex. automatisering av affärsprocesser), resonemang över dokument (t.ex. sammanfattning av rapporter) eller kodgenerering. Det är din favorit för strukturerade uppgifter på hög nivå.

Operatör: Utmärker sig i röriga, API-fria miljöer som att navigera i klumpiga användargränssnitt, styra robotar eller ta itu med spelliknande uppgifter. Om det handlar om interaktion i realtid med oförutsägbara system är VLA kung.

8. Mental modell: Planerare + Görare

Tänk på LLM-agenten som planeraren: den delar upp komplexa uppgifter i tydliga, logiska mål.

VLA-operatören är den som utför dessa mål genom att direkt interagera med pixlar eller fysiska system. En kontrollant (ett annat system eller en agent) övervakar resultaten för att säkerställa framgång.

$CODEC

1,2K

Codecflow Optr erbjuder ett enhetligt tillvägagångssätt för att skapa agenter som ser, resonerar och agerar i digitala och fysiska miljöer. Oavsett om det handlar om att automatisera arbetsflöden på skrivbordet, styra robotarmar eller testa i simulering använder den samma mentala modell och primitiver.

Louround 🥂21 aug. 2025

Dips in a bull market are meant to be bought, especially on projects with big catalysts

We all know that AI is the narrative of this cycle, started by ai16z and Virtuals last year.

My bet is that the market will focus on more complex and sophisticated technologies such as VLAs, and let me tell you why.

LLMs (Large Language Models) mainly read and write text: they’re great at explaining, planning, and generating instructions, but they don’t by themselves control motors or interact with the physical world (as you may have experienced with chatgpt).

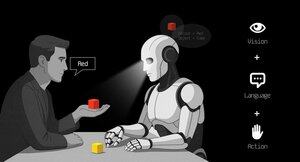

VLAs (Vision Language Action models) differ from LLMs as they are multimodal systems that look at things (vision), understand instructions (language), and directly produce actions. It's like telling a robot to pick up a red cup and then moving its arm to do it.

VLAs are trained on examples that pair images/video + instructions + real action traces (how a robot actually moved), and they must run fast and safely in real time. LLMs on their side are trained on huge text collections and focus on reasoning and language tasks.

TL;DR LLMs think and speak whil VLAs see, reason, and act.

As you can see, VLAs are a major addition to LLMs and will notably enable the next 0 to 1 innovation in the overall economy that will be robotics. A majority of investment funds are allocating a large part of their investments into this sector, seen as the next logical evolution in the AI industry.

I already made a post a while ago on the current leader in the crypto market, @codecopenflow, which did not raise capital (fair launch) yet is shipping cutting-edge products and currently sitting at $23M FDV.

For information, other crypto competitors raised $20m ( @openmind_agi) at what is probably a $200M to $300M ++ FDV while no product or community has been built and shipped yet.

What makes Codec a leading project in the sector is that they tackle a crucial bottleneck in robotics and AI, which is the difficulty to have all the AI tools interact together. Let me explain.

Their latest release, OPTR (operator), is a toolkit that helps build operators capable of interacting on multiple platforms such as robots, desktops, browsers, or simulations. The objective of an operator is to see, reason, and act (VLA) in both digital (computers) and physical (robots) worlds.

This toolkit serves as core infrastructure for robotic teams aiming to test their product and enhance the overall process by providing a unified experience instead of separate ones for web browsers, simulations, or robots. This essentially makes the operator adaptive and autonomous regardless of its environment.

So you get it, it will save big time for companies and developers who previously had to go through each step manually and where you can save time you can save money.

It will also enable Codec to build their own operator projects and launch new capacities relatively fast onto the market, notably through their marketplace.

TL;DR: You probably have seen videos of robots folding tissues, sorting boxes, or jumping on various elements. They have all been trained for this very specific use case, and unfortunately, one skill cannot be re-used in another environment like a human could do. OPTR from Codec solves this by making skills transferrable among environments and situations, making training and development a lot faster and cheaper for enterprises.

This is why Codec is so interesting in unifying the digital world with the physical world.

$CODEC, Coded.

1,19K

Forskningsföretaget @epochbiz (av @ZoomerOracle) publicerade en detaljerad forskningsartikel om CodecFlow.

Missa inte det.

$CODEC

epoch_19 aug. 2025

$CODEC är inställt på att vara det bästa alternativet som onchain-spel för robotik

Forskningsartikel om @codecopenflow är nu live på 🤖

1,23K

Topp

Rankning

Favoriter