Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

CodecFlow

Warstwa wykonawcza dla operatorów AI i robotyki na @Solana

CA:69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

VLAs są wciąż bardzo nowe i wiele osób ma trudności zrozumieć różnicę między VLA a LLM.

Oto głęboka analiza, jak te systemy AI różnią się w zakresie rozumowania, percepcji i działania. Część 1.

Rozłóżmy kluczowe różnice i jak agenci AI opakowani wokół LLM różnią się od agentów operatorów, którzy używają modeli VLA:

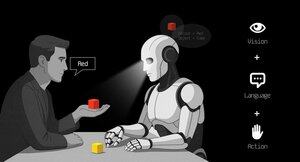

1. Percepcja: Jak postrzegają świat

Agent (LLM): Przetwarza tekst lub dane strukturalne, np. JSON, API, a czasami obrazy. To jak mózg pracujący z czystymi, abstrakcyjnymi danymi. Pomyśl o czytaniu instrukcji lub analizowaniu arkusza kalkulacyjnego. Świetnie sprawdza się w uporządkowanych środowiskach, ale jest ograniczony przez to, co mu dostarczono.

Operator (VLA): Widzi surowe, rzeczywiste piksele z kamer, plus dane z czujników (np. dotyk, pozycja) i propriocepcję (samoświadomość ruchu). To jak nawigowanie po świecie za pomocą oczu i zmysłów, doskonale radzi sobie w dynamicznych, chaotycznych warunkach, takich jak interfejsy użytkownika czy przestrzenie fizyczne.

2. Działanie: Jak wchodzą w interakcje

Agent: Działa, wywołując funkcje, narzędzia lub API. Wyobraź sobie to jako menedżera wysyłającego precyzyjne instrukcje, takie jak „zarezerwuj lot przez API Expedia”. To jest zamierzone, ale polega na wstępnie zbudowanych narzędziach i jasnych interfejsach.

Operator: Wykonuje ciągłe, niskopoziomowe działania, takie jak poruszanie kursorem myszy, pisanie lub kontrolowanie stawów robota. To jak wykwalifikowany pracownik bezpośrednio manipulujący otoczeniem, idealny do zadań wymagających precyzji w czasie rzeczywistym.

3. Kontrola: Jak podejmują decyzje

Agent: Podąża za wolną, refleksyjną pętlą: planuj, wywołaj narzędzie, oceń wynik, powtórz. Jest ograniczony przez tokeny (ograniczony przez przetwarzanie tekstu) i sieć (czekając na odpowiedzi API). To sprawia, że jest metodyczny, ale powolny w zadaniach w czasie rzeczywistym.

Operator: Działa, podejmując decyzje krok po kroku w ciasnej pętli sprzężenia zwrotnego. Pomyśl o tym jak o graczu reagującym natychmiast na to, co jest na ekranie. Ta szybkość umożliwia płynne interakcje, ale wymaga solidnego przetwarzania w czasie rzeczywistym.

4. Dane do nauki: Co napędza ich trening

Agent: Trenuje na ogromnych zbiorach tekstów, instrukcjach, dokumentacji lub zestawach danych RAG (Retrieval-Augmented Generation). Uczy się z książek, kodu lub FAQ, doskonale radząc sobie z rozumowaniem na podstawie wiedzy strukturalnej.

Operator: Uczy się z demonstracji (np. filmów ludzi wykonujących zadania), logów teleoperacji lub sygnałów nagród. To jak nauka przez obserwację i praktykę, idealne do zadań, w których brakuje wyraźnych instrukcji.

5. Tryby awarii: Gdzie się psują

Agent: Skłonny do halucynacji (wymyślanie odpowiedzi) lub kruchych długoterminowych planów, które się rozpadają, jeśli jeden krok zawiedzie. To jak strateg, który zbytnio analizuje lub źle odczytuje sytuację.

Operator: Napotyka przesunięcie kowariancji (gdy dane treningowe nie odpowiadają warunkom rzeczywistym) lub kumulujące się błędy w kontroli (małe błędy narastają). To jak kierowca tracący kontrolę na nieznanej drodze.

6. Infra: Technologia stojąca za nimi

Agent: Polega na podpowiedzi/routerze, aby zdecydować, które narzędzia wywołać, rejestrze narzędzi dla dostępnych funkcji oraz pamięci/RAG dla kontekstu. To modułowa konfiguracja, jak centrum dowodzenia organizujące zadania.

Operator: Potrzebuje pipeline'ów do przetwarzania wideo, serwera akcji do kontroli w czasie rzeczywistym, osłony bezpieczeństwa, aby zapobiec szkodliwym działaniom, oraz bufora odtwarzania do przechowywania doświadczeń. To system wysokowydajny, zbudowany do dynamicznych środowisk.

7. Gdzie każdy błyszczy: Ich mocne strony

Agent: Dominuje w przepływach pracy z czystymi API (np. automatyzacja procesów biznesowych), rozumowaniem na podstawie dokumentów (np. podsumowywanie raportów) lub generowaniem kodu. To twój wybór do uporządkowanych, wysokopoziomowych zadań.

Operator: Doskonale radzi sobie w chaotycznych, pozbawionych API środowiskach, takich jak nawigowanie po nieporęcznych interfejsach użytkownika, kontrolowanie robotów lub podejmowanie zadań przypominających gry. Jeśli to wymaga interakcji w czasie rzeczywistym z nieprzewidywalnymi systemami, VLA jest królem.

8. Model mentalny: Planista + Wykonawca

Pomyśl o agencie LLM jako o planista: dzieli złożone zadania na jasne, logiczne cele.

Operator VLA to wykonawca, realizujący te cele poprzez bezpośrednią interakcję z pikselami lub systemami fizycznymi. Kontroler (inny system lub agent) monitoruje wyniki, aby zapewnić sukces.

$CODEC

1,21K

Codecflow Optr oferuje zintegrowane podejście do budowania agentów, którzy widzą, rozumują i działają w środowiskach cyfrowych i fizycznych. Niezależnie od tego, czy automatyzujesz przepływy pracy na komputerze, kontrolujesz ramiona robotów, czy testujesz w symulacji, używa tego samego modelu mentalnego i prymitywów.

Louround 🥂21 sie 2025

Dips in a bull market are meant to be bought, especially on projects with big catalysts

We all know that AI is the narrative of this cycle, started by ai16z and Virtuals last year.

My bet is that the market will focus on more complex and sophisticated technologies such as VLAs, and let me tell you why.

LLMs (Large Language Models) mainly read and write text: they’re great at explaining, planning, and generating instructions, but they don’t by themselves control motors or interact with the physical world (as you may have experienced with chatgpt).

VLAs (Vision Language Action models) differ from LLMs as they are multimodal systems that look at things (vision), understand instructions (language), and directly produce actions. It's like telling a robot to pick up a red cup and then moving its arm to do it.

VLAs are trained on examples that pair images/video + instructions + real action traces (how a robot actually moved), and they must run fast and safely in real time. LLMs on their side are trained on huge text collections and focus on reasoning and language tasks.

TL;DR LLMs think and speak whil VLAs see, reason, and act.

As you can see, VLAs are a major addition to LLMs and will notably enable the next 0 to 1 innovation in the overall economy that will be robotics. A majority of investment funds are allocating a large part of their investments into this sector, seen as the next logical evolution in the AI industry.

I already made a post a while ago on the current leader in the crypto market, @codecopenflow, which did not raise capital (fair launch) yet is shipping cutting-edge products and currently sitting at $23M FDV.

For information, other crypto competitors raised $20m ( @openmind_agi) at what is probably a $200M to $300M ++ FDV while no product or community has been built and shipped yet.

What makes Codec a leading project in the sector is that they tackle a crucial bottleneck in robotics and AI, which is the difficulty to have all the AI tools interact together. Let me explain.

Their latest release, OPTR (operator), is a toolkit that helps build operators capable of interacting on multiple platforms such as robots, desktops, browsers, or simulations. The objective of an operator is to see, reason, and act (VLA) in both digital (computers) and physical (robots) worlds.

This toolkit serves as core infrastructure for robotic teams aiming to test their product and enhance the overall process by providing a unified experience instead of separate ones for web browsers, simulations, or robots. This essentially makes the operator adaptive and autonomous regardless of its environment.

So you get it, it will save big time for companies and developers who previously had to go through each step manually and where you can save time you can save money.

It will also enable Codec to build their own operator projects and launch new capacities relatively fast onto the market, notably through their marketplace.

TL;DR: You probably have seen videos of robots folding tissues, sorting boxes, or jumping on various elements. They have all been trained for this very specific use case, and unfortunately, one skill cannot be re-used in another environment like a human could do. OPTR from Codec solves this by making skills transferrable among environments and situations, making training and development a lot faster and cheaper for enterprises.

This is why Codec is so interesting in unifying the digital world with the physical world.

$CODEC, Coded.

1,2K

Firma badawcza @epochbiz (od @ZoomerOracle) opublikowała szczegółowy artykuł badawczy na temat CodecFlow.

Nie przegap tego.

$CODEC

epoch_19 sie 2025

$CODEC przygotowuje się, aby stać się najlepszą opcją jako gra onchain dla Robotyki

Artykuł badawczy o @codecopenflow jest już dostępny na 🤖

1,24K

Najlepsze

Ranking

Ulubione