Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

CodecFlow

Uitvoeringslaag voor AI-operators en robotica op @Solana

CA:69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

VLAs zijn nog steeds erg nieuw en veel mensen vinden het moeilijk om het verschil tussen VLAs en LLMs te begrijpen.

Hier is een diepgaande analyse van hoe deze AI-systemen verschillen in redeneren, waarnemen en handelen. Deel 1.

Laten we de belangrijkste onderscheidingen uiteenzetten en hoe AI-agenten die zijn verpakt rond een LLM verschillen van operatoragenten die VLA-modellen gebruiken:

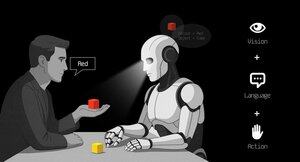

1. Waarnemen: Hoe ze de wereld waarnemen

Agent (LLM): Verwerkt tekst of gestructureerde gegevens, bijvoorbeeld JSON, API's en soms afbeeldingen. Het is als een brein dat werkt met schone, geabstraheerde invoer. Denk aan het lezen van een handleiding of het parseren van een spreadsheet. Geweldig voor gestructureerde omgevingen, maar beperkt door wat er aan wordt gevoed.

Operator (VLA): Ziet ruwe, realtime pixels van camera's, plus sensorgegevens (bijv. aanraking, positie) en proprioceptie (zelfbewustzijn van beweging). Het is als navigeren door de wereld met ogen en zintuigen, gedijend in dynamische, rommelige omgevingen zoals UI's of fysieke ruimtes.

2. Handelen: Hoe ze interageren

Agent: Handelt door functies, tools of API's aan te roepen. Stel je voor dat het een manager is die precieze instructies geeft zoals "boek een vlucht via de Expedia API." Het is doelbewust, maar afhankelijk van vooraf gebouwde tools en duidelijke interfaces.

Operator: Voert continue, laagdrempelige acties uit, zoals het bewegen van een muiscursor, typen of het bedienen van robotgewrichten. Het is als een bekwame werknemer die direct de omgeving manipuleert, ideaal voor taken die real-time precisie vereisen.

3. Controle: Hoe ze beslissingen nemen

Agent: Volgt een langzame, reflectieve cyclus: plannen, een tool aanroepen, het resultaat evalueren, herhalen. Het is token-gebonden (beperkt door tekstverwerking) en netwerk-gebonden (wachtend op API-responsen). Dit maakt het methodisch maar traag voor real-time taken.

Operator: Werkt, neemt stapgewijze beslissingen in een strakke feedbacklus. Denk aan een gamer die onmiddellijk reageert op wat er op het scherm staat. Deze snelheid maakt vloeiende interactie mogelijk, maar vereist robuuste real-time verwerking.

4. Gegevens om te leren: Wat hun training aandrijft

Agent: Getraind op enorme tekstcorpora, instructies, documentatie of RAG (Retrieval-Augmented Generation) datasets. Het leert van boeken, code of FAQ's, en excelleert in redeneren over gestructureerde kennis.

Operator: Leert van demonstraties (bijv. video's van mensen die taken uitvoeren), teleoperatielogs of beloningssignalen. Het is als leren door te kijken en te oefenen, perfect voor taken waar expliciete instructies schaars zijn.

5. Faalmodi: Waar ze falen

Agent: Gevoelig voor hallucinatie (het verzinnen van antwoorden) of broze langetermijnplannen die in elkaar storten als één stap faalt. Het is als een strateeg die te veel nadenkt of de situatie verkeerd inschat.

Operator: Heeft te maken met covariate shift (wanneer trainingsgegevens niet overeenkomen met de echte wereldomstandigheden) of cumulatieve fouten in controle (kleine fouten die zich opstapelen). Het is als een bestuurder die de controle verliest op een onbekende weg.

6. Infra: De technologie erachter

Agent: Vertrouwt op een prompt/router om te beslissen welke tools aan te roepen, een toolregister voor beschikbare functies, en geheugen/RAG voor context. Het is een modulaire opzet, als een commandocentrum dat taken coördineert.

Operator: Heeft video-invoerpijplijnen nodig, een act server voor real-time controle, een veiligheidsbescherming om schadelijke acties te voorkomen, en een replaybuffer om ervaringen op te slaan. Het is een high-performance systeem dat is gebouwd voor dynamische omgevingen.

7. Waar elk uitblinkt: Hun sterke punten

Agent: Dominant in workflows met schone API's (bijv. automatisering van bedrijfsprocessen), redeneren over documenten (bijv. samenvatten van rapporten) of codegeneratie. Het is je go-to voor gestructureerde, hoog-niveau taken.

Operator: Uitblinkt in rommelige, API-loze omgevingen zoals het navigeren door onhandige UI's, het bedienen van robots of het aanpakken van game-achtige taken. Als het gaat om real-time interactie met onvoorspelbare systemen, is VLA koning.

8. Mentale Model: Planner + Doener

Denk aan de LLM Agent als de planner: het breekt complexe taken op in duidelijke, logische doelen.

De VLA Operator is de doener, die die doelen uitvoert door direct te interageren met pixels of fysieke systemen. Een controleur (een ander systeem of agent) monitort de uitkomsten om succes te waarborgen.

$CODEC

1,2K

Codecflow Optr biedt een uniforme benadering voor het bouwen van agenten die kunnen zien, redeneren en handelen in digitale en fysieke omgevingen. Of het nu gaat om het automatiseren van desktopworkflows, het besturen van robotarmen of het testen in simulatie, het gebruikt hetzelfde mentale model en dezelfde primitieve elementen.

Louround 🥂21 aug 2025

Dips in a bull market are meant to be bought, especially on projects with big catalysts

We all know that AI is the narrative of this cycle, started by ai16z and Virtuals last year.

My bet is that the market will focus on more complex and sophisticated technologies such as VLAs, and let me tell you why.

LLMs (Large Language Models) mainly read and write text: they’re great at explaining, planning, and generating instructions, but they don’t by themselves control motors or interact with the physical world (as you may have experienced with chatgpt).

VLAs (Vision Language Action models) differ from LLMs as they are multimodal systems that look at things (vision), understand instructions (language), and directly produce actions. It's like telling a robot to pick up a red cup and then moving its arm to do it.

VLAs are trained on examples that pair images/video + instructions + real action traces (how a robot actually moved), and they must run fast and safely in real time. LLMs on their side are trained on huge text collections and focus on reasoning and language tasks.

TL;DR LLMs think and speak whil VLAs see, reason, and act.

As you can see, VLAs are a major addition to LLMs and will notably enable the next 0 to 1 innovation in the overall economy that will be robotics. A majority of investment funds are allocating a large part of their investments into this sector, seen as the next logical evolution in the AI industry.

I already made a post a while ago on the current leader in the crypto market, @codecopenflow, which did not raise capital (fair launch) yet is shipping cutting-edge products and currently sitting at $23M FDV.

For information, other crypto competitors raised $20m ( @openmind_agi) at what is probably a $200M to $300M ++ FDV while no product or community has been built and shipped yet.

What makes Codec a leading project in the sector is that they tackle a crucial bottleneck in robotics and AI, which is the difficulty to have all the AI tools interact together. Let me explain.

Their latest release, OPTR (operator), is a toolkit that helps build operators capable of interacting on multiple platforms such as robots, desktops, browsers, or simulations. The objective of an operator is to see, reason, and act (VLA) in both digital (computers) and physical (robots) worlds.

This toolkit serves as core infrastructure for robotic teams aiming to test their product and enhance the overall process by providing a unified experience instead of separate ones for web browsers, simulations, or robots. This essentially makes the operator adaptive and autonomous regardless of its environment.

So you get it, it will save big time for companies and developers who previously had to go through each step manually and where you can save time you can save money.

It will also enable Codec to build their own operator projects and launch new capacities relatively fast onto the market, notably through their marketplace.

TL;DR: You probably have seen videos of robots folding tissues, sorting boxes, or jumping on various elements. They have all been trained for this very specific use case, and unfortunately, one skill cannot be re-used in another environment like a human could do. OPTR from Codec solves this by making skills transferrable among environments and situations, making training and development a lot faster and cheaper for enterprises.

This is why Codec is so interesting in unifying the digital world with the physical world.

$CODEC, Coded.

1,19K

Onderzoeksbureau @epochbiz (van @ZoomerOracle) heeft een gedetailleerd onderzoeksrapport gepubliceerd over CodecFlow.

Mis het niet.

$CODEC

epoch_19 aug 2025

$CODEC is zich aan het voorbereiden om de beste optie te zijn als onchain spel voor Robotica

Onderzoeksartikel over @codecopenflow is nu live op 🤖

1,22K

Boven

Positie

Favorieten