Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

CodecFlow

Уровень выполнения для операторов ИИ и робототехники на @Solana

CA:69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

VLAs все еще очень новы, и многим людям трудно понять разницу между VLAs и LLMs.

Вот глубокое погружение в то, как эти AI-системы различаются в рассуждениях, восприятии и действиях. Часть 1.

Давайте разберем ключевые отличия и то, как AI-агенты, обернутые вокруг LLM, отличаются от операторов, использующих модели VLA:

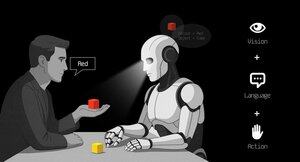

1. Восприятие: Как они воспринимают мир

Агент (LLM): Обрабатывает текст или структурированные данные, например, JSON, API и иногда изображения. Это как мозг, работающий с чистыми, абстрактными входными данными. Подумайте о чтении руководства или разборе таблицы. Отлично подходит для структурированных сред, но ограничен тем, что ему подают.

Оператор (VLA): Видит сырые, реальные пиксели с камер, плюс данные датчиков (например, касание, положение) и проприоцепцию (осознание собственного движения). Это как навигация по миру с помощью глаз и чувств, процветая в динамичных, беспорядочных условиях, таких как пользовательские интерфейсы или физические пространства.

2. Действие: Как они взаимодействуют

Агент: Действует, вызывая функции, инструменты или API. Представьте, что это менеджер, отправляющий точные инструкции, такие как "забронировать рейс через Expedia API". Это целенаправленно, но зависит от заранее подготовленных инструментов и четких интерфейсов.

Оператор: Выполняет непрерывные, низкоуровневые действия, такие как перемещение курсора мыши, набор текста или управление суставами робота. Это как опытный работник, непосредственно манипулирующий окружающей средой, идеально подходит для задач, требующих точности в реальном времени.

3. Контроль: Как они принимают решения

Агент: Следует медленному, рефлексивному циклу: план, вызов инструмента, оценка результата, повторение. Он ограничен токенами (ограничен обработкой текста) и сетью (ожидание ответов API). Это делает его методичным, но медленным для задач в реальном времени.

Оператор: Работает, принимая пошаговые решения в плотном цикле обратной связи. Подумайте о геймере, мгновенно реагирующем на то, что на экране. Эта скорость позволяет плавному взаимодействию, но требует надежной обработки в реальном времени.

4. Данные для обучения: Что питает их обучение

Агент: Обучен на обширных текстовых корпусах, инструкциях, документации или наборах данных RAG (Увеличенное Генерирование Извлечений). Он учится на книгах, коде или часто задаваемых вопросах, отлично разбираясь в рассуждениях на основе структурированных знаний.

Оператор: Учится на демонстрациях (например, видео людей, выполняющих задачи), логах телеприсутствия или сигналах вознаграждения. Это как обучение через наблюдение и практику, идеально подходит для задач, где явные инструкции редки.

5. Режимы отказа: Где они ломаются

Агент: Склонен к галлюцинациям (выдумыванию ответов) или хрупким долгосрочным планам, которые разваливаются, если один шаг не удается. Это как стратег, который слишком много думает или неправильно интерпретирует ситуацию.

Оператор: Сталкивается с изменением ковариат (когда обучающие данные не соответствуют условиям реального мира) или накопительными ошибками в управлении (маленькие ошибки накапливаются). Это как водитель, теряющий контроль на незнакомой дороге.

6. Инфраструктура: Технология за ними

Агент: Полагается на подсказку/маршрутизатор, чтобы решить, какие инструменты вызывать, реестр инструментов для доступных функций и память/RAG для контекста. Это модульная настройка, как командный центр, организующий задачи.

Оператор: Нуждается в каналах ввода видео, сервере действий для управления в реальном времени, защитном щите для предотвращения вредных действий и буфере воспроизведения для хранения опыта. Это высокопроизводительная система, созданная для динамичных условий.

7. Где каждый блестит: Их сильные стороны

Агент: Превосходит в рабочих процессах с чистыми API (например, автоматизация бизнес-процессов), рассуждениях по документам (например, резюмирование отчетов) или генерации кода. Это ваш выбор для структурированных, высокоуровневых задач.

Оператор: Превосходит в беспорядочных, без API средах, таких как навигация по громоздким пользовательским интерфейсам, управление роботами или выполнение игровых задач. Если это связано с взаимодействием в реальном времени с непредсказуемыми системами, VLA - король.

8. Ментальная модель: Планировщик + Исполнитель

Подумайте о LLM Агенте как о планировщике: он разбивает сложные задачи на четкие, логические цели.

Оператор VLA - это исполнитель, который выполняет эти цели, непосредственно взаимодействуя с пикселями или физическими системами. Проверяющий (другая система или агент) контролирует результаты, чтобы обеспечить успех.

$CODEC

1,2K

Codecflow Optr предлагает единый подход к созданию агентов, которые видят, рассуждают и действуют в цифровых и физических средах. Независимо от того, автоматизируют ли они рабочие процессы на настольных компьютерах, управляют ли роботизированными руками или проводят тестирование в симуляции, они используют одну и ту же ментальную модель и примитивы.

Louround 🥂21 авг. 2025 г.

Dips in a bull market are meant to be bought, especially on projects with big catalysts

We all know that AI is the narrative of this cycle, started by ai16z and Virtuals last year.

My bet is that the market will focus on more complex and sophisticated technologies such as VLAs, and let me tell you why.

LLMs (Large Language Models) mainly read and write text: they’re great at explaining, planning, and generating instructions, but they don’t by themselves control motors or interact with the physical world (as you may have experienced with chatgpt).

VLAs (Vision Language Action models) differ from LLMs as they are multimodal systems that look at things (vision), understand instructions (language), and directly produce actions. It's like telling a robot to pick up a red cup and then moving its arm to do it.

VLAs are trained on examples that pair images/video + instructions + real action traces (how a robot actually moved), and they must run fast and safely in real time. LLMs on their side are trained on huge text collections and focus on reasoning and language tasks.

TL;DR LLMs think and speak whil VLAs see, reason, and act.

As you can see, VLAs are a major addition to LLMs and will notably enable the next 0 to 1 innovation in the overall economy that will be robotics. A majority of investment funds are allocating a large part of their investments into this sector, seen as the next logical evolution in the AI industry.

I already made a post a while ago on the current leader in the crypto market, @codecopenflow, which did not raise capital (fair launch) yet is shipping cutting-edge products and currently sitting at $23M FDV.

For information, other crypto competitors raised $20m ( @openmind_agi) at what is probably a $200M to $300M ++ FDV while no product or community has been built and shipped yet.

What makes Codec a leading project in the sector is that they tackle a crucial bottleneck in robotics and AI, which is the difficulty to have all the AI tools interact together. Let me explain.

Their latest release, OPTR (operator), is a toolkit that helps build operators capable of interacting on multiple platforms such as robots, desktops, browsers, or simulations. The objective of an operator is to see, reason, and act (VLA) in both digital (computers) and physical (robots) worlds.

This toolkit serves as core infrastructure for robotic teams aiming to test their product and enhance the overall process by providing a unified experience instead of separate ones for web browsers, simulations, or robots. This essentially makes the operator adaptive and autonomous regardless of its environment.

So you get it, it will save big time for companies and developers who previously had to go through each step manually and where you can save time you can save money.

It will also enable Codec to build their own operator projects and launch new capacities relatively fast onto the market, notably through their marketplace.

TL;DR: You probably have seen videos of robots folding tissues, sorting boxes, or jumping on various elements. They have all been trained for this very specific use case, and unfortunately, one skill cannot be re-used in another environment like a human could do. OPTR from Codec solves this by making skills transferrable among environments and situations, making training and development a lot faster and cheaper for enterprises.

This is why Codec is so interesting in unifying the digital world with the physical world.

$CODEC, Coded.

1,19K

Исследовательская компания @epochbiz (от @ZoomerOracle) опубликовала подробное исследование о CodecFlow.

Не пропустите это.

$CODEC

epoch_19 авг. 2025 г.

$CODEC готовится стать лучшим вариантом для onchain игры в области робототехники

Научная статья о @codecopenflow теперь доступна 🤖

1,22K

Топ

Рейтинг

Избранное