Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

CodecFlow

Lapisan eksekusi untuk Operator AI dan Robotika di @Solana

CA: 69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

VLA masih sangat baru dan banyak orang merasa sulit untuk memahami perbedaan antara VLA dan LLM.

Berikut adalah penyelaman mendalam tentang bagaimana sistem AI ini berbeda dalam penalaran, penginderaan, dan tindakan. Bagian 1.

Mari kita uraikan perbedaan utama dan bagaimana agen AI yang dibungkus di sekitar LLM berbeda dari agen operator yang menggunakan model VLA:

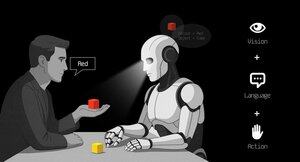

1. Rasa: Bagaimana mereka memandang dunia

Agen (LLM): Memproses teks atau data terstruktur misalnya JSON, API, dan terkadang gambar. Ini seperti otak yang bekerja dengan input yang bersih dan abstrak. Pikirkan membaca manual atau mengurai spreadsheet. Bagus untuk lingkungan terstruktur tetapi dibatasi oleh apa yang diumpankan ke dalamnya.

Operator (VLA): Melihat piksel mentah dan real-time dari kamera, ditambah data sensor (misalnya, sentuhan, posisi) dan proprioception (kesadaran diri akan gerakan). Ini seperti menavigasi dunia dengan mata dan indera, berkembang dalam pengaturan yang dinamis dan berantakan seperti UI atau ruang fisik.

2. Bertindak: Bagaimana mereka berinteraksi

Agen: Bertindak dengan memanggil fungsi, alat, atau API. Bayangkan sebagai manajer yang mengirimkan instruksi yang tepat seperti "pesan penerbangan melalui Expedia API." Ini disengaja tetapi bergantung pada alat yang dibuat sebelumnya dan antarmuka yang jelas.

Operator: Menjalankan tindakan tingkat rendah yang berkelanjutan, seperti menggerakkan kursor mouse, mengetik, atau mengontrol sambungan robot. Ini seperti pekerja terampil yang secara langsung memanipulasi lingkungan, ideal untuk tugas-tugas yang membutuhkan presisi waktu nyata.

3. Kontrol: Bagaimana mereka membuat keputusan

Agen: Mengikuti perulangan reflektif yang lambat: rencanakan, panggil alat, evaluasi hasilnya, ulangi. Ini terikat token (dibatasi oleh pemrosesan teks) dan terikat jaringan (menunggu respons API). Ini membuatnya metodis tetapi lamban untuk tugas waktu nyata.

Operator: Beroperasi, membuat keputusan bertahap dalam lingkaran umpan balik yang ketat. Anggap saja seperti seorang gamer yang bereaksi langsung terhadap apa yang ada di layar. Kecepatan ini memungkinkan interaksi yang lancar tetapi menuntut pemrosesan real-time yang kuat.

4. Data untuk Dipelajari: Apa yang mendorong pelatihan mereka

Agen: Dilatih pada corpora teks, instruksi, dokumentasi, atau himpunan data RAG (Retrieval-Augmented Generation) yang luas. Itu belajar dari buku, kode, atau FAQ, unggul dalam penalaran daripada pengetahuan terstruktur.

Operator: Belajar dari demonstrasi (misalnya, video manusia melakukan tugas), log teleoperasi, atau sinyal hadiah. Ini seperti belajar dengan menonton dan berlatih, sempurna untuk tugas-tugas di mana instruksi eksplisit langka.

5. Mode Kegagalan: Di mana mereka rusak

Agen: Rentan terhadap halusinasi (mengarang jawaban) atau rencana jangka panjang rapuh yang berantakan jika satu langkah gagal. Ini seperti ahli strategi yang terlalu memikirkan atau salah membaca situasi.

Operator: Menghadapi pergeseran kovariat (ketika data pelatihan tidak sesuai dengan kondisi dunia nyata) atau kesalahan majemuk dalam kontrol (bola salju kesalahan kecil). Ini seperti pengemudi yang kehilangan kendali di jalan yang tidak dikenal.

6. Infra: Teknologi di balik mereka

Agen: Mengandalkan prompt/router untuk memutuskan alat mana yang akan dipanggil, registri alat untuk fungsi yang tersedia, dan memori/RAG untuk konteks. Ini adalah pengaturan modular, seperti pusat komando yang mengatur tugas.

Operator: Memerlukan alur penyerapan video, server tindakan untuk kontrol waktu nyata, perisai pengaman untuk mencegah tindakan berbahaya, dan buffer pemutaran ulang untuk menyimpan pengalaman. Ini adalah sistem berkinerja tinggi yang dibangun untuk lingkungan dinamis.

7. Di Mana Masing-masing Bersinar: Sweet spot mereka

Agen: Mendominasi alur kerja dengan API yang bersih (misalnya, mengotomatiskan proses bisnis), penalaran atas dokumen (misalnya, meringkas laporan), atau pembuatan kode. Ini adalah pilihan Anda untuk tugas tingkat tinggi yang terstruktur.

Operator: Unggul dalam lingkungan yang berantakan dan tanpa API seperti menavigasi UI yang kikuk, mengontrol robot, atau menangani tugas seperti game. Jika melibatkan interaksi real-time dengan sistem yang tidak dapat diprediksi, VLA adalah raja.

8. Model Mental: Perencana + Pelaku

Pikirkan Agen LLM sebagai perencana: ia memecah tugas kompleks menjadi tujuan yang jelas dan logis.

Operator VLA adalah pelakunya, melaksanakan tujuan tersebut dengan berinteraksi langsung dengan piksel atau sistem fisik. Pemeriksa (sistem atau agen lain) memantau hasil untuk memastikan keberhasilan.

$CODEC

1,19K

Codecflow Optr menawarkan pendekatan terpadu untuk membangun agen yang melihat, bernalar, dan bertindak di lingkungan digital dan fisik. Baik mengotomatiskan alur kerja desktop, mengontrol lengan robot, atau menguji dalam simulasi, ini menggunakan model mental dan primitif yang sama.

Louround 🥂21 Agu 2025

Dips in a bull market are meant to be bought, especially on projects with big catalysts

We all know that AI is the narrative of this cycle, started by ai16z and Virtuals last year.

My bet is that the market will focus on more complex and sophisticated technologies such as VLAs, and let me tell you why.

LLMs (Large Language Models) mainly read and write text: they’re great at explaining, planning, and generating instructions, but they don’t by themselves control motors or interact with the physical world (as you may have experienced with chatgpt).

VLAs (Vision Language Action models) differ from LLMs as they are multimodal systems that look at things (vision), understand instructions (language), and directly produce actions. It's like telling a robot to pick up a red cup and then moving its arm to do it.

VLAs are trained on examples that pair images/video + instructions + real action traces (how a robot actually moved), and they must run fast and safely in real time. LLMs on their side are trained on huge text collections and focus on reasoning and language tasks.

TL;DR LLMs think and speak whil VLAs see, reason, and act.

As you can see, VLAs are a major addition to LLMs and will notably enable the next 0 to 1 innovation in the overall economy that will be robotics. A majority of investment funds are allocating a large part of their investments into this sector, seen as the next logical evolution in the AI industry.

I already made a post a while ago on the current leader in the crypto market, @codecopenflow, which did not raise capital (fair launch) yet is shipping cutting-edge products and currently sitting at $23M FDV.

For information, other crypto competitors raised $20m ( @openmind_agi) at what is probably a $200M to $300M ++ FDV while no product or community has been built and shipped yet.

What makes Codec a leading project in the sector is that they tackle a crucial bottleneck in robotics and AI, which is the difficulty to have all the AI tools interact together. Let me explain.

Their latest release, OPTR (operator), is a toolkit that helps build operators capable of interacting on multiple platforms such as robots, desktops, browsers, or simulations. The objective of an operator is to see, reason, and act (VLA) in both digital (computers) and physical (robots) worlds.

This toolkit serves as core infrastructure for robotic teams aiming to test their product and enhance the overall process by providing a unified experience instead of separate ones for web browsers, simulations, or robots. This essentially makes the operator adaptive and autonomous regardless of its environment.

So you get it, it will save big time for companies and developers who previously had to go through each step manually and where you can save time you can save money.

It will also enable Codec to build their own operator projects and launch new capacities relatively fast onto the market, notably through their marketplace.

TL;DR: You probably have seen videos of robots folding tissues, sorting boxes, or jumping on various elements. They have all been trained for this very specific use case, and unfortunately, one skill cannot be re-used in another environment like a human could do. OPTR from Codec solves this by making skills transferrable among environments and situations, making training and development a lot faster and cheaper for enterprises.

This is why Codec is so interesting in unifying the digital world with the physical world.

$CODEC, Coded.

1,18K

Perusahaan riset @epochbiz (oleh @ZoomerOracle) menerbitkan sebuah penelitian terperinci tentang CodecFlow.

Jangan lewatkan.

$CODEC

epoch_19 Agu 2025

$CODEC sedang menyiapkan untuk menjadi opsi terbaik sebagai permainan onchain untuk Robotika

Artikel penelitian tentang @codecopenflow sekarang ditayangkan 🤖

1,22K

Teratas

Peringkat

Favorit