Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

CodecFlow

Ausführungsschicht für KI-Bediener und Robotik auf @Solana

CA:69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpumpe

Wir freuen uns, bekannt zu geben, dass $CODEC jetzt live und handelbar auf @MachineDEX auf @peaq, der Layer 1 für die Maschinenwirtschaft, ist.

Mit der bevorstehenden Integration in das optr SDK können Betreiber On-Chain-Maschinen auf peaq mit Telemetrie, prüfbaren Sitzungen, DIDs und Belohnungen steuern.

1

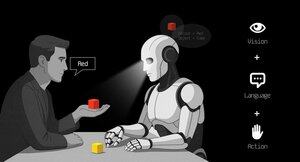

VLAs sind noch sehr neu und viele Menschen finden es schwierig, den Unterschied zwischen VLAs und LLMs zu verstehen.

Hier ist ein tiefer Einblick, wie sich diese KI-Systeme in Bezug auf Denken, Wahrnehmung und Handeln unterscheiden. Teil 1.

Lass uns die wichtigsten Unterschiede aufschlüsseln und wie KI-Agenten, die um ein LLM gewickelt sind, sich von Operator-Agenten unterscheiden, die VLA-Modelle verwenden:

1. Wahrnehmung: Wie sie die Welt wahrnehmen

Agent (LLM): Verarbeitet Text oder strukturierte Daten, z.B. JSON, APIs und manchmal Bilder. Es ist wie ein Gehirn, das mit sauberen, abstrahierten Eingaben arbeitet. Denk an das Lesen eines Handbuchs oder das Parsen einer Tabelle. Großartig für strukturierte Umgebungen, aber begrenzt durch das, was ihm zugeführt wird.

Operator (VLA): Sieht rohe, Echtzeit-Pixel von Kameras, plus Sensordaten (z.B. Berührung, Position) und Propriozeption (Selbstwahrnehmung der Bewegung). Es ist wie das Navigieren in der Welt mit Augen und Sinnen, das in dynamischen, chaotischen Umgebungen wie UIs oder physischen Räumen gedeiht.

2. Handeln: Wie sie interagieren

Agent: Handelt, indem er Funktionen, Werkzeuge oder APIs aufruft. Stell dir vor, es ist ein Manager, der präzise Anweisungen gibt wie „Buche einen Flug über die Expedia-API.“ Es ist absichtlich, aber abhängig von vorgefertigten Werkzeugen und klaren Schnittstellen.

Operator: Führt kontinuierliche, niedrigstufige Aktionen aus, wie das Bewegen eines Mauszeigers, Tippen oder das Steuern von Robotergelenken. Es ist wie ein geschickter Arbeiter, der direkt mit der Umgebung interagiert, ideal für Aufgaben, die Echtzeit-Präzision erfordern.

3. Kontrolle: Wie sie Entscheidungen treffen

Agent: Folgt einem langsamen, reflektierenden Zyklus: planen, ein Werkzeug aufrufen, das Ergebnis bewerten, wiederholen. Es ist tokengebunden (begrenzt durch die Textverarbeitung) und netzwerkgebunden (wartet auf API-Antworten). Das macht es methodisch, aber träge für Echtzeitanwendungen.

Operator: Arbeitet, trifft schrittweise Entscheidungen in einem engen Feedback-Zyklus. Denk an einen Gamer, der sofort auf das reagiert, was auf dem Bildschirm zu sehen ist. Diese Geschwindigkeit ermöglicht flüssige Interaktionen, erfordert jedoch eine robuste Echtzeitverarbeitung.

4. Daten zum Lernen: Was ihr Training antreibt

Agent: Wird auf riesigen Textkorpora, Anleitungen, Dokumentationen oder RAG (Retrieval-Augmented Generation) Datensätzen trainiert. Er lernt aus Büchern, Code oder FAQs und glänzt im Denken über strukturiertes Wissen.

Operator: Lernt aus Demonstrationen (z.B. Videos von Menschen, die Aufgaben ausführen), Teleoperationsprotokollen oder Belohnungssignalen. Es ist wie Lernen durch Zuschauen und Üben, perfekt für Aufgaben, bei denen explizite Anweisungen rar sind.

5. Fehlermodi: Wo sie versagen

Agent: Neigt zu Halluzinationen (Antworten erfinden) oder brüchigen Langzeitplänen, die zusammenbrechen, wenn ein Schritt fehlschlägt. Es ist wie ein Stratege, der überdenkt oder die Situation falsch einschätzt.

Operator: Sieht sich einer Kovariatenverschiebung gegenüber (wenn die Trainingsdaten nicht mit den realen Bedingungen übereinstimmen) oder kumulierten Fehlern in der Steuerung (kleine Fehler summieren sich). Es ist wie ein Fahrer, der auf einer unbekannten Straße die Kontrolle verliert.

6. Infrastruktur: Die Technik dahinter

Agent: Vertraut auf einen Prompt/Router, um zu entscheiden, welche Werkzeuge aufgerufen werden, ein Werkzeugverzeichnis für verfügbare Funktionen und Speicher/RAG für den Kontext. Es ist ein modulares Setup, wie ein Kommandozentrum, das Aufgaben orchestriert.

Operator: Benötigt Videoeingabepipelines, einen Aktionsserver für die Echtzeitsteuerung, einen Sicherheitsmechanismus, um schädliche Aktionen zu verhindern, und einen Replay-Puffer, um Erfahrungen zu speichern. Es ist ein Hochleistungssystem, das für dynamische Umgebungen gebaut ist.

7. Wo jeder glänzt: Ihre Stärken

Agent: Dominierend in Workflows mit sauberen APIs (z.B. Automatisierung von Geschäftsprozessen), Denken über Dokumente (z.B. Zusammenfassen von Berichten) oder Code-Generierung. Es ist dein Ansprechpartner für strukturierte, hochrangige Aufgaben.

Operator: Exzellent in chaotischen, API-losen Umgebungen wie dem Navigieren durch unhandliche UIs, dem Steuern von Robotern oder dem Bewältigen von spielähnlichen Aufgaben. Wenn es um Echtzeitinteraktion mit unvorhersehbaren Systemen geht, ist VLA der König.

8. Mentales Modell: Planer + Macher

Denk an den LLM-Agenten als den Planer: Er zerlegt komplexe Aufgaben in klare, logische Ziele.

Der VLA-Operator ist der Macher, der diese Ziele umsetzt, indem er direkt mit Pixeln oder physischen Systemen interagiert. Ein Prüfer (ein anderes System oder ein Agent) überwacht die Ergebnisse, um den Erfolg sicherzustellen.

$CODEC

1,22K

Codecflow Optr bietet einen einheitlichen Ansatz zum Erstellen von Agenten, die in digitalen und physischen Umgebungen sehen, denken und handeln. Ob bei der Automatisierung von Desktop-Workflows, der Steuerung von Roboterarmen oder dem Testen in Simulationen, es verwendet dasselbe mentale Modell und dieselben Primitiven.

Louround 🥂21. Aug. 2025

Dips in a bull market are meant to be bought, especially on projects with big catalysts

We all know that AI is the narrative of this cycle, started by ai16z and Virtuals last year.

My bet is that the market will focus on more complex and sophisticated technologies such as VLAs, and let me tell you why.

LLMs (Large Language Models) mainly read and write text: they’re great at explaining, planning, and generating instructions, but they don’t by themselves control motors or interact with the physical world (as you may have experienced with chatgpt).

VLAs (Vision Language Action models) differ from LLMs as they are multimodal systems that look at things (vision), understand instructions (language), and directly produce actions. It's like telling a robot to pick up a red cup and then moving its arm to do it.

VLAs are trained on examples that pair images/video + instructions + real action traces (how a robot actually moved), and they must run fast and safely in real time. LLMs on their side are trained on huge text collections and focus on reasoning and language tasks.

TL;DR LLMs think and speak whil VLAs see, reason, and act.

As you can see, VLAs are a major addition to LLMs and will notably enable the next 0 to 1 innovation in the overall economy that will be robotics. A majority of investment funds are allocating a large part of their investments into this sector, seen as the next logical evolution in the AI industry.

I already made a post a while ago on the current leader in the crypto market, @codecopenflow, which did not raise capital (fair launch) yet is shipping cutting-edge products and currently sitting at $23M FDV.

For information, other crypto competitors raised $20m ( @openmind_agi) at what is probably a $200M to $300M ++ FDV while no product or community has been built and shipped yet.

What makes Codec a leading project in the sector is that they tackle a crucial bottleneck in robotics and AI, which is the difficulty to have all the AI tools interact together. Let me explain.

Their latest release, OPTR (operator), is a toolkit that helps build operators capable of interacting on multiple platforms such as robots, desktops, browsers, or simulations. The objective of an operator is to see, reason, and act (VLA) in both digital (computers) and physical (robots) worlds.

This toolkit serves as core infrastructure for robotic teams aiming to test their product and enhance the overall process by providing a unified experience instead of separate ones for web browsers, simulations, or robots. This essentially makes the operator adaptive and autonomous regardless of its environment.

So you get it, it will save big time for companies and developers who previously had to go through each step manually and where you can save time you can save money.

It will also enable Codec to build their own operator projects and launch new capacities relatively fast onto the market, notably through their marketplace.

TL;DR: You probably have seen videos of robots folding tissues, sorting boxes, or jumping on various elements. They have all been trained for this very specific use case, and unfortunately, one skill cannot be re-used in another environment like a human could do. OPTR from Codec solves this by making skills transferrable among environments and situations, making training and development a lot faster and cheaper for enterprises.

This is why Codec is so interesting in unifying the digital world with the physical world.

$CODEC, Coded.

1,21K

Top

Ranking

Favoriten