Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

CodecFlow

Capa de ejecución para operadores de IA y robótica en @Solana

CA:69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

Los VLA son todavía muy nuevos y a mucha gente le resulta difícil entender la diferencia entre los VLA y los LLM.

Aquí hay una inmersión profunda en cómo estos sistemas de IA difieren en razonamiento, detección y acción. Parte 1.

Analicemos las distinciones clave y cómo los agentes de IA envueltos alrededor de un LLM difieren de los agentes operadores que usan modelos VLA:

1. Sentido: Cómo perciben el mundo

Agente (LLM): Procesa texto o datos estructurados, por ejemplo, JSON, API y, a veces, imágenes. Es como un cerebro que trabaja con entradas limpias y abstractas. Piense en leer un manual o analizar una hoja de cálculo. Ideal para entornos estructurados, pero limitado por lo que se le proporciona.

Operador (VLA): ve píxeles sin procesar en tiempo real de las cámaras, además de datos del sensor (por ejemplo, tacto, posición) y propiocepción (autoconciencia del movimiento). Es como navegar por el mundo con ojos y sentidos, prosperando en entornos dinámicos y desordenados como interfaces de usuario o espacios físicos.

2. Actuar: cómo interactúan

Agente: Actúa llamando a funciones, herramientas o API. Imagínelo como un gerente que envía instrucciones precisas como "reservar un vuelo a través de la API de Expedia". Es deliberado, pero se basa en herramientas prediseñadas e interfaces claras.

Operador: Ejecuta acciones continuas de bajo nivel, como mover el cursor del mouse, escribir o controlar las articulaciones del robot. Es como un trabajador calificado que manipula directamente el entorno, ideal para tareas que requieren precisión en tiempo real.

3. Control: cómo toman decisiones

Agente: Sigue un bucle lento y reflexivo: planificar, llamar a una herramienta, evaluar el resultado, repetir. Está vinculado a tokens (limitado por el procesamiento de texto) y a la red (esperando respuestas de API). Esto lo hace metódico pero lento para las tareas en tiempo real.

Operador: Opera, tomando decisiones paso a paso en un estrecho ciclo de retroalimentación. Piense en ello como un jugador que reacciona instantáneamente a lo que está en la pantalla. Esta velocidad permite la interacción de fluidos, pero exige un procesamiento robusto en tiempo real.

4. Datos para aprender: qué alimenta su entrenamiento

Agente: Entrenado en vastos corpus de texto, instrucciones, documentación o conjuntos de datos RAG (Retrieval-Augmented Generation). Aprende de libros, código o preguntas frecuentes, sobresaliendo en el razonamiento sobre el conocimiento estructurado.

Operador: Aprende de demostraciones (por ejemplo, videos de humanos realizando tareas), registros de teleoperación o señales de recompensa. Es como aprender observando y practicando, perfecto para tareas donde las instrucciones explícitas son escasas.

5. Modos de falla: dónde se rompen

Agente: Propenso a la alucinación (inventar respuestas) o planes frágiles a largo plazo que se desmoronan si falla un paso. Es como un estratega que piensa demasiado o malinterpreta la situación.

Operador: se enfrenta a un cambio de covariable (cuando los datos de entrenamiento no coinciden con las condiciones del mundo real) o a errores compuestos en el control (pequeños errores que se convierten en una bola de nieve). Es como un conductor que pierde el control en una carretera desconocida.

6. Infra: la tecnología detrás de ellos

Agente: se basa en un prompt/router para decidir a qué herramientas llamar, un registro de herramientas para las funciones disponibles y memoria/RAG para el contexto. Es una configuración modular, como un centro de comando que orquesta tareas.

Operador: necesita canalizaciones de ingesta de vídeo, un servidor de acciones para el control en tiempo real, un escudo de seguridad para evitar acciones dañinas y un búfer de reproducción para almacenar experiencias. Es un sistema de alto rendimiento diseñado para entornos dinámicos.

7. Donde brilla cada uno: sus puntos dulces

Agente: Domina los flujos de trabajo con API limpias (por ejemplo, automatización de procesos comerciales), razonamiento sobre documentos (por ejemplo, resumen de informes) o generación de código. Es su opción para tareas estructuradas y de alto nivel.

Operador: Sobresale en entornos desordenados y sin API, como navegar por interfaces de usuario torpes, controlar robots o abordar tareas similares a las de un juego. Si implica interacción en tiempo real con sistemas impredecibles, VLA es el rey.

8. Modelo mental: planificador + hacedor

Piense en el agente de LLM como el planificador: divide tareas complejas en objetivos claros y lógicos.

El operador VLA es el hacedor, ejecutando esos objetivos interactuando directamente con píxeles o sistemas físicos. Un verificador (otro sistema o agente) monitorea los resultados para garantizar el éxito.

$CODEC

1.19K

Codecflow Optr ofrece un enfoque unificado para crear agentes que ven, razonan y actúan en entornos digitales y físicos. Ya sea automatizando flujos de trabajo de escritorio, controlando brazos robóticos o probando en simulación, utiliza el mismo modelo mental y primitivas.

Louround 🥂21 ago 2025

Dips in a bull market are meant to be bought, especially on projects with big catalysts

We all know that AI is the narrative of this cycle, started by ai16z and Virtuals last year.

My bet is that the market will focus on more complex and sophisticated technologies such as VLAs, and let me tell you why.

LLMs (Large Language Models) mainly read and write text: they’re great at explaining, planning, and generating instructions, but they don’t by themselves control motors or interact with the physical world (as you may have experienced with chatgpt).

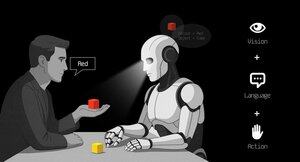

VLAs (Vision Language Action models) differ from LLMs as they are multimodal systems that look at things (vision), understand instructions (language), and directly produce actions. It's like telling a robot to pick up a red cup and then moving its arm to do it.

VLAs are trained on examples that pair images/video + instructions + real action traces (how a robot actually moved), and they must run fast and safely in real time. LLMs on their side are trained on huge text collections and focus on reasoning and language tasks.

TL;DR LLMs think and speak whil VLAs see, reason, and act.

As you can see, VLAs are a major addition to LLMs and will notably enable the next 0 to 1 innovation in the overall economy that will be robotics. A majority of investment funds are allocating a large part of their investments into this sector, seen as the next logical evolution in the AI industry.

I already made a post a while ago on the current leader in the crypto market, @codecopenflow, which did not raise capital (fair launch) yet is shipping cutting-edge products and currently sitting at $23M FDV.

For information, other crypto competitors raised $20m ( @openmind_agi) at what is probably a $200M to $300M ++ FDV while no product or community has been built and shipped yet.

What makes Codec a leading project in the sector is that they tackle a crucial bottleneck in robotics and AI, which is the difficulty to have all the AI tools interact together. Let me explain.

Their latest release, OPTR (operator), is a toolkit that helps build operators capable of interacting on multiple platforms such as robots, desktops, browsers, or simulations. The objective of an operator is to see, reason, and act (VLA) in both digital (computers) and physical (robots) worlds.

This toolkit serves as core infrastructure for robotic teams aiming to test their product and enhance the overall process by providing a unified experience instead of separate ones for web browsers, simulations, or robots. This essentially makes the operator adaptive and autonomous regardless of its environment.

So you get it, it will save big time for companies and developers who previously had to go through each step manually and where you can save time you can save money.

It will also enable Codec to build their own operator projects and launch new capacities relatively fast onto the market, notably through their marketplace.

TL;DR: You probably have seen videos of robots folding tissues, sorting boxes, or jumping on various elements. They have all been trained for this very specific use case, and unfortunately, one skill cannot be re-used in another environment like a human could do. OPTR from Codec solves this by making skills transferrable among environments and situations, making training and development a lot faster and cheaper for enterprises.

This is why Codec is so interesting in unifying the digital world with the physical world.

$CODEC, Coded.

1.18K

La firma de investigación @epochbiz (por @ZoomerOracle) publicó un artículo de investigación detallado sobre CodecFlow.

No te lo pierdas.

$CODEC

epoch_19 ago 2025

$CODEC se está configurando para ser la mejor opción como juego en cadena para la robótica

El artículo de investigación sobre @codecopenflow ya está disponible en 🤖

1.21K

Populares

Ranking

Favoritas