Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

CodecFlow

Рівень виконання для операторів штучного інтелекту та робототехніки на @Solana

CA:69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

VLA все ще дуже нові, і багатьом людям важко зрозуміти різницю між VLA та LLM.

Ось глибоке занурення в те, як ці системи штучного інтелекту відрізняються за міркуваннями, відчуттями та діями. Частина 1.

Давайте розберемо ключові відмінності та те, чим агенти штучного інтелекту, обгорнуті навколо LLM, відрізняються від операторів-агентів, які використовують моделі VLA:

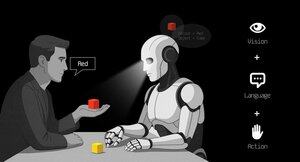

1. Почуття: як вони сприймають світ

Агент (LLM): обробляє текст або структуровані дані, наприклад JSON, API та іноді зображення. Це схоже на роботу мозку з чистими, абстрактними вхідними даними. Подумайте про читання посібника або розбір електронної таблиці. Чудово підходить для структурованих середовищ, але обмежений тим, що в нього подаються.

Оператор (VLA): бачить необроблені пікселі з камер у реальному часі, а також дані датчиків (наприклад, дотик, положення) та пропріоцепцію (самоусвідомлення руху). Це схоже на навігацію світом за допомогою очей і почуттів, процвітаючи в динамічних, безладних умовах, таких як інтерфейси користувача або фізичний простір.

2. Дія: як вони взаємодіють

Агент: діє шляхом виклику функцій, інструментів або API. Уявіть собі, що менеджер надсилає точні інструкції на кшталт «забронюйте рейс через Expedia API». Це навмисно, але покладається на готові інструменти та зрозумілі інтерфейси.

Оператор: виконує безперервні дії на низькому рівні, як-от переміщення курсору миші, набір тексту або керування суглобами роботів. Це схоже на кваліфікованого працівника, який безпосередньо маніпулює навколишнім середовищем, що ідеально підходить для завдань, що вимагають точності в реальному часі.

3. Контроль: як вони приймають рішення

Агент: Слідує повільному, рефлексивному циклу: плануйте, викликайте інструмент, оцінюйте результат, повторюйте. Він прив'язаний до токена (обмежений обробкою тексту) і прив'язаний до мережі (очікує відповідей API). Це робить його методичним, але млявим для завдань у реальному часі.

Оператор: Діє, приймаючи поетапні рішення в щільному циклі зворотного зв'язку. Думайте про це як про геймера, який миттєво реагує на те, що відображається на екрані. Така швидкість забезпечує плавну взаємодію, але вимагає надійної обробки в режимі реального часу.

4. Дані для вивчення: що живить їхнє навчання

Агент: Навчений на великих текстових корпусах, інструкціях, документації або наборах даних RAG (Retrieval-Augmented Generation). Він вчиться з книг, коду або поширених запитань, перевершуючи структуровані знання.

Оператор: навчається з демонстрацій (наприклад, відео, на яких люди виконують завдання), журналів телеоперацій або сигналів винагороди. Це схоже на навчання, спостерігаючи та практикуючись, ідеально підходить для завдань, де чітких інструкцій мало.

5. Режими відмови: де вони ламаються

Агент: схильний до галюцинацій (вигадування відповідей) або крихких довгострокових планів, які руйнуються, якщо один крок не вдається. Це схоже на стратега, який надмірно обмірковує або неправильно розуміє ситуацію.

Оператор: стикається з коваріатним зсувом (коли дані тренування не відповідають реальним умовам) або складними помилками в управлінні (маленькі помилки сніжний ком). Це схоже на те, як водій втрачає контроль на незнайомій дорозі.

6. Infra: технології, що стоять за ними

Агент: покладається на підказку/маршрутизатор, щоб вирішити, які інструменти викликати, реєстр інструментів для доступних функцій та пам'ять/RAG для контексту. Це модульна система, як командний центр, який оркеструє завдання.

Оператор: потрібні конвеєри прийому відео, сервер дій для керування в реальному часі, захисний щит для запобігання шкідливим діям і буфер повторів для зберігання вражень. Це високопродуктивна система, створена для динамічних середовищ.

7. Де кожен сяє: їхні солодкі місця

Агент: домінує в робочих процесах з чистими API (наприклад, автоматизація бізнес-процесів), обґрунтуванням документів (наприклад, узагальнення звітів) або генерацією коду. Це ваш вибір для структурованих завдань високого рівня.

Оператор: чудово справляється з безладними середовищами без API, як-от навігація в незграбних інтерфейсах користувача, керування роботами або вирішення завдань, схожих на гру. Якщо це передбачає взаємодію в реальному часі з непередбачуваними системами, VLA є королем.

8. Ментальна модель: планувальник + виконавець

Думайте про LLM Agent як про планувальника: він розбиває складні завдання на чіткі, логічні цілі.

Оператор VLA є виконавцем, який виконує ці цілі, безпосередньо взаємодіючи з пікселями або фізичними системами. Чекер (інша система або агент) стежить за результатами, щоб забезпечити успіх.

$CODEC

1,19K

Codecflow Optr пропонує уніфікований підхід до створення агентів, які бачать, міркують і діють у цифровому та фізичному середовищі. Незалежно від того, чи це автоматизація робочих процесів на робочому столі, керування роботами-маніпуляторами чи тестування в симуляції, він використовує одну й ту саму ментальну модель і примітиви.

Louround 🥂21 серп. 2025 р.

Dips in a bull market are meant to be bought, especially on projects with big catalysts

We all know that AI is the narrative of this cycle, started by ai16z and Virtuals last year.

My bet is that the market will focus on more complex and sophisticated technologies such as VLAs, and let me tell you why.

LLMs (Large Language Models) mainly read and write text: they’re great at explaining, planning, and generating instructions, but they don’t by themselves control motors or interact with the physical world (as you may have experienced with chatgpt).

VLAs (Vision Language Action models) differ from LLMs as they are multimodal systems that look at things (vision), understand instructions (language), and directly produce actions. It's like telling a robot to pick up a red cup and then moving its arm to do it.

VLAs are trained on examples that pair images/video + instructions + real action traces (how a robot actually moved), and they must run fast and safely in real time. LLMs on their side are trained on huge text collections and focus on reasoning and language tasks.

TL;DR LLMs think and speak whil VLAs see, reason, and act.

As you can see, VLAs are a major addition to LLMs and will notably enable the next 0 to 1 innovation in the overall economy that will be robotics. A majority of investment funds are allocating a large part of their investments into this sector, seen as the next logical evolution in the AI industry.

I already made a post a while ago on the current leader in the crypto market, @codecopenflow, which did not raise capital (fair launch) yet is shipping cutting-edge products and currently sitting at $23M FDV.

For information, other crypto competitors raised $20m ( @openmind_agi) at what is probably a $200M to $300M ++ FDV while no product or community has been built and shipped yet.

What makes Codec a leading project in the sector is that they tackle a crucial bottleneck in robotics and AI, which is the difficulty to have all the AI tools interact together. Let me explain.

Their latest release, OPTR (operator), is a toolkit that helps build operators capable of interacting on multiple platforms such as robots, desktops, browsers, or simulations. The objective of an operator is to see, reason, and act (VLA) in both digital (computers) and physical (robots) worlds.

This toolkit serves as core infrastructure for robotic teams aiming to test their product and enhance the overall process by providing a unified experience instead of separate ones for web browsers, simulations, or robots. This essentially makes the operator adaptive and autonomous regardless of its environment.

So you get it, it will save big time for companies and developers who previously had to go through each step manually and where you can save time you can save money.

It will also enable Codec to build their own operator projects and launch new capacities relatively fast onto the market, notably through their marketplace.

TL;DR: You probably have seen videos of robots folding tissues, sorting boxes, or jumping on various elements. They have all been trained for this very specific use case, and unfortunately, one skill cannot be re-used in another environment like a human could do. OPTR from Codec solves this by making skills transferrable among environments and situations, making training and development a lot faster and cheaper for enterprises.

This is why Codec is so interesting in unifying the digital world with the physical world.

$CODEC, Coded.

1,18K

Дослідницька фірма @epochbiz (за @ZoomerOracle) опублікувала детальну статтю про CodecFlow.

Не пропустіть.

$CODEC

epoch_19 серп. 2025 р.

$CODEC налаштовується як найкращий варіант як ончейн гра для робототехніки

Наукова стаття про @codecopenflow вже опублікована 🤖

1,21K

Найкращі

Рейтинг

Вибране